博文

《自然》:中国如何创建 AI 模型 DeepSeek 并震惊世界  精选

精选

|

《自然》:中国如何创建 AI 模型 DeepSeek 并震惊世界

政府政策、慷慨的资金和人工智能毕业生的管道帮助中国公司创建了奇迹。

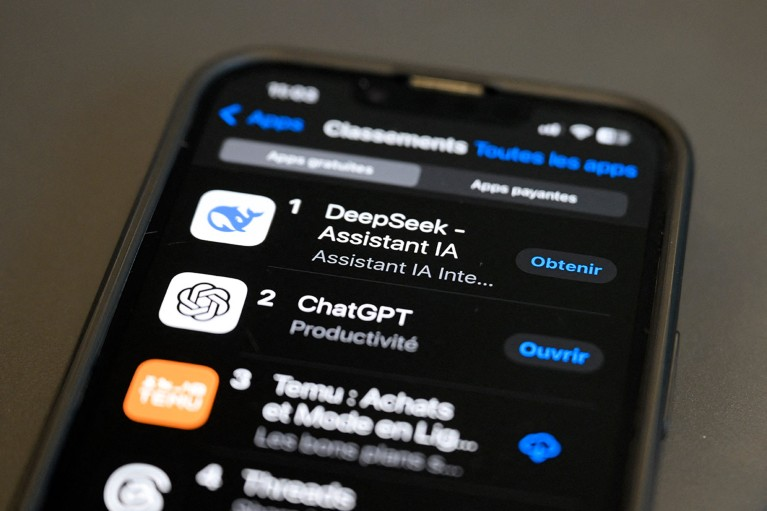

深度求索(DeepSeek)研发的大型语言模型R1,在部分任务上的表现可与聊天机器人ChatGPT的开发者OpenAI所开发的模型相媲美。

中国科技初创企业深度求索发布了两款大型语言模型(LLMs),在性能上可与美国科技巨头开发的主流工具相抗衡,且研发成本和所需算力仅为后者的一小部分,这一成果在科技界引起了轰动。

1月20日,这家总部位于杭州的公司发布了部分开源的 “推理” 模型DeepSeek - R1。该模型在解决某些科学问题时,达到了与OpenAI去年年底推出的最先进大型语言模型o1相近的水平。OpenAI位于加利福尼亚州旧金山。本周早些时候,深度求索又推出了另一款模型Janus - Pro - 7B,它能像OpenAI的DALL - E 3以及伦敦Stability AI公司开发的Stable Diffusion一样,根据文本提示生成图像。

如果说DeepSeek - R1的表现让许多国外人士感到惊讶,那么中国国内的研究人员则表示,这家初创公司的成功在预料之中,这与中国政府希望成为全球人工智能(AI)领军者的目标相符。

在北京中国科学院计算技术研究所从事AI芯片研究的计算机科学家陈云霁表示,鉴于风险投资对开发大型语言模型的公司投入巨大,且中国拥有众多在包括人工智能在内的科学、技术、工程或数学领域获得博士学位的人才,像深度求索这样的公司在中国出现是必然的。“如果没有深度求索,也会有其他中国的大型语言模型取得出色成果。”

事实上,这样的公司还有不少。1月29日,科技巨头阿里巴巴发布了其迄今为止最先进的大型语言模型通义千问2.5 - Max。阿里巴巴称该模型的性能优于深度求索去年12月发布的另一款大型语言模型V3。上周,月之暗面(Moonshot AI)和字节跳动发布了新的推理模型Kimi 1.5和1.5 - pro,两家公司宣称这两款模型在某些基准测试中的表现优于o1。

政府重点推动

2017年,中国政府宣布计划到2030年使中国成为全球人工智能领域的领军者,并要求该行业到2025年实现重大人工智能突破,“使技术和应用达到世界领先水平”。

培养 “人工智能人才” 成为当务之急。根据华盛顿特区乔治城大学安全与新兴技术中心(CSET)的一份报告,到2022年,中国教育部已批准440所大学开设人工智能相关本科专业。伊利诺伊州芝加哥市智库“宏观中国”(MacroPolo)的数据显示,同年,中国培养的顶尖人工智能研究人员数量几乎占全球的一半,而美国仅占18%。

澳大利亚悉尼科技大学专注于中国创新研究的科学政策研究员张越表示,深度求索可能受益于政府在人工智能教育和人才培养方面的投入,其中包括大量奖学金、研究资助以及学术界与产业界的合作。例如,她补充说,由北京科技公司百度牵头的深度学习技术与应用国家工程实验室等政府支持项目,已培养了数千名人工智能专家。

虽然很难找到深度求索员工的确切数据,但公司创始人梁文峰向中国媒体透露,公司已从中国顶尖大学招募了毕业生和博士生。张越说,公司领导团队的一些成员年龄不到35岁,他们见证了中国作为科技超级大国的崛起。“他们深受创新自主的动力驱使。”

39岁的梁文峰本人就是一位年轻的企业家,毕业于杭州的顶尖学府浙江大学计算机科学专业。近十年前,他与人共同创立了对冲基金远瞻资本(High - Flyer),并于2023年成立了深度求索。

在CSET研究中国人工智能人才的雅各布·费尔德戈伊斯表示,国家推动人工智能模型开发生态系统的政策,在吸引资金和人才方面,对深度求索这样的公司有所帮助。

但费尔德戈伊斯指出,尽管大学中人工智能课程不断增加,但并不清楚有多少学生能够获得专门的人工智能学位,以及他们所学技能是否符合公司需求。他说,近年来中国人工智能公司抱怨 “这些课程的毕业生达不到他们期望的质量”,这导致一些公司与大学展开合作。

“受限条件下的效率”

科学家们表示,深度求索成功最令人印象深刻的或许是,它在2022年美国政府实施出口管制,限制中国获取先进人工智能计算芯片的情况下,开发出了DeepSeek - R1和Janus - Pro - 7B。

张越说,深度求索的领导层体现了一种典型的中国式创新方式,即在受限条件下注重效率。不过,她补充说,该公司尚未披露其使用硬件的具体细节。

深度求索表示,其使用了约2000块美国芯片制造商英伟达生产的H800芯片来训练去年12月发布的模型DeepSeek - V3。在基准测试中,该模型的表现优于OpenAI去年5月推出的大型语言模型GPT - 4o。相比之下,位于加利福尼亚州门洛帕克的Meta公司在7月发布的复杂大型语言模型Llama 3.1 405B,使用了超过16000块更先进的英伟达H100芯片。远瞻资本曾在2022年社交媒体平台微信上发布消息称,其拥有10000块英伟达较旧的A100芯片,深度求索可能也能使用这些芯片。深度求索使用性能相对较弱的芯片,可能降低了模型的开发成本。“我们面临的问题从来都不是资金,而是高端芯片的禁令,” 梁文峰在2024年7月向中国媒体表示。

深度求索采用了多种方法来提高模型效率。例如,它采用了 “专家混合” 架构,这是一种机器学习方法,比传统技术训练模型的速度更快,且所需参数更少。悉尼大学的计算机科学家徐畅表示,这使公司能够使用更少的芯片来训练模型。它还采用了另一种技术的创新版本,即多头潜在注意力,该技术使模型能够以更少的内存存储更多数据。

本周,有媒体报道称OpenAI正在审查有关深度求索使用OpenAI模型的输出结果来训练自身模型的说法。(OpenAI正因知识产权侵权问题被新闻机构起诉)。深度求索尚未对这些说法做出回应。瑞士伯尔尼的开源科学平台Hugging Face的研究员刘易斯·滕斯托尔表示,即便这种说法属实,也 “丝毫不会削弱” 深度求索开发R1的成就。他说,他们的进步在于使用一种学习方法为大型语言模型注入 “推理” 能力,并且已有实验重复了这一成果。Hugging Face正在牵头一个项目,试图从零开始重现R1。“我预计我们很快就能知道是否真的需要来自OpenAI的合成数据,” 他说。

香港大学专注于创新研究的科学政策研究员王彦博表示,深度求索的成就可以为那些有志于发展人工智能,但缺乏资金和硬件,无法采用硅谷标准方式训练大规模大型语言模型的国家提供蓝图。“这可能会催生一大批新模型,” 他说。

https://blog.sciencenet.cn/blog-41174-1471101.html

上一篇:南美洲独有的大型地洞可能是史前巨兽地懒的洞穴

下一篇:为何挠痒感觉舒服:挠痒对免疫系统的益处