博文

如何避免AI深度伪造的危害

|

GPT给人们带来的方便性让这种技术快速扩展,但人们很快发现这种技术容易出现伪造现象,就是所谓的理直气壮地胡说,对于专业人员来说,这种错误并不难识别,但也不是所有人能简单识别的。这意味着这种伪造信息会对社会和科学带来潜在巨大危害。如何克服这种问题,《自然》杂志最近的文章对这种问题进行了探讨。

本文后续内容使用讯飞翻译。

今年6月,在2024年美国总统初选前夕的政治斗争中,一系列照片被发布,显示唐纳德·特朗普拥抱他的前医学顾问安东尼·福奇。在一些照片中,特朗普尴尬地亲吻着福奇的脸。福奇是一位卫生官员,因在新冠疫情期间推广口罩和疫苗而被一些美国保守派诋毁。

How to stop AI deepfakes from sinking society — and science (nature.com)

“很明显”这些照片是假的,加州大学伯克利分校的计算机科学家哈尼·法里德说,他是审查这些照片的许多专家之一。在对三张照片进行仔细检查后,发现特朗普的头发奇怪地模糊不清,背景中的文本毫无意义,手臂和手的位置不自然,特朗普可见耳朵的细节不正确。这些都是——目前——生成性人工智能(AI)的标志性特征,也称为合成AI。

由基于深度学习的AI驱动的文本到图像生成器制作的这种深度伪造图片和视频现在很常见。虽然欺诈者长期以来一直使用欺骗来获利、影响舆论或发动战争,但现在可以快速轻松地创建和传播大量令人信服的虚假内容,再加上公众意识的缺乏,这是一个日益增长的威胁。北卡罗来纳州达勒姆市杜克大学的AI计算机科学家辛西娅·鲁丁说:“人们不习惯生成技术。它不是逐渐演变而来的;就像‘砰’的一声,突然间就出现了。所以,你不会有那种需要的怀疑态度。”

现在有几十个系统可供普通用户为任何目的生成几乎任何内容,无论是在TikTok上为娱乐目的生成深度伪造的汤姆·克鲁斯视频;还是通过将校园枪击案受害者的相貌还原制作宣传枪支管制的视频广告;或者是伪造来自亲人的求救电话诈骗受害者数十万美元。深度伪造视频可以实时在实时视频通话中生成。今年早些时候,美联储主席杰罗姆·鲍威尔与一名他认为是乌克兰总统泽连斯基的人进行了视频通话,但实际上并非如此。

人工智能生成的内容数量尚不清楚,但据认为正在激增。学者们通常引用的估计是,大约90%的所有互联网内容可能在几年内都是合成的。“其他所有东西都会被这种噪音淹没。”鲁丁说,这将使找到真实、有用内容变得困难。她还说,搜索引擎和社交媒体只会放大错误信息。“我们一直在推荐和传播所有这些垃圾。现在我们将要生成垃圾。”

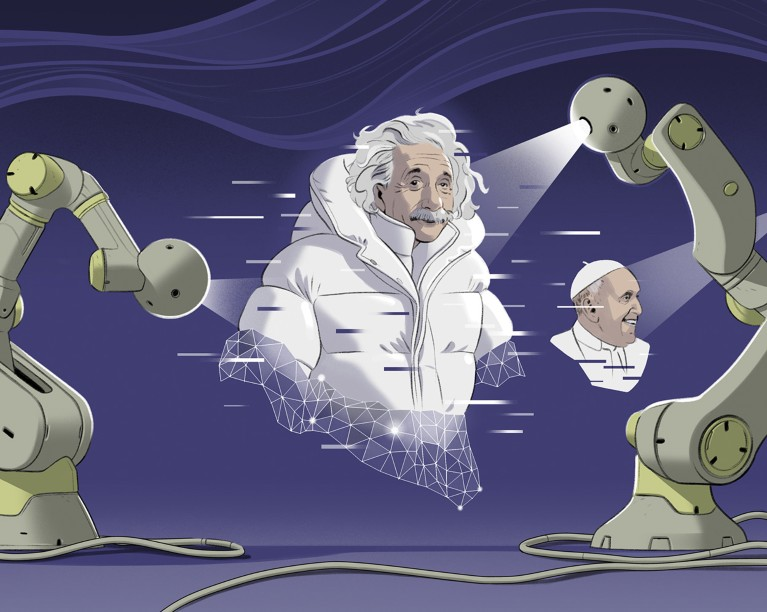

尽管许多合成媒体是为了娱乐和乐趣而制作的,比如教皇弗朗西斯穿着设计师羽绒外套的病毒图片,但有些是有议程驱动的,有些是恶意的——包括大量未经同意的色情作品,其中某人的脸被转移到另一具身体上。即使是单一的合成文件也能引起轰动:例如,今年5月在美国五角大楼爆炸事件中广为传播的一幅由AI生成的图片导致股市短暂下跌。合成内容的存在还使得不良行为者可以通过简单地声称它是假的来抹去真实的不当行为证据。

人类真正知道自己应该信任哪里的能力正在消失。这对于民主是一个真正的问题,”英国兰卡斯特大学的心理学家索菲·南丁格尔说,她研究生成性人工智能的影响。“我们需要对此采取行动,而且要迅速。这已经是一个巨大威胁。”她还说,这个问题在未来一两年将成为一个大问题,美国、俄罗斯和英国都计划进行重大选举。

一些专家表示,AI生成的虚假内容也可能对科学产生巨大影响。他们担心,生成性人工智能系统的快速发展能力可能使不道德的研究人员更容易发布虚假数据和图像(参见本文末尾的“被欺骗的科学”)。

目前,一些合成内容包含了泄露线索,比如一只手上有六根手指的人的图片。但生成性人工智能每天都在变得更好。“我们还需要几个月的时间,人们才能肉眼分辨不出来,”洛杉矶南加州大学的信息科学家和计算机工程师瓦伊尔·阿卜德-阿马尔杰德说。

所有这些都使研究人员争相研究如何利用人工智能生成深度假的威力做好事,同时开发工具防范坏事。有两种技术防御方法:在生成内容时主动标记真实或虚假内容;在发布后使用检测器捕捉虚假内容。宾夕法尼亚州立大学帕克分校媒体效果研究实验室的创始人、心理学家希亚姆·桑达说,这两种方法都不是完美的解决方案,但它们通过增加障碍来阻止虚假行为,从而有所帮助。“如果你是专门的恶意行为者,你肯定可以走得很远。关键是让他们很难做到,”他说。

短期内,技术将是至关重要的,但“从长远来看,也许我们可以更多地考虑教育和监管。”今年6月,欧盟通过了《人工智能法案》,成为全球领导者,该法案正等待欧盟政府其他两个部门的决策。“我们肯定会从中学到重要经验教训,无论他们是否做得对,”南丁格尔说。

这只是一个幻想吗? 对于研究人员来说,生成性人工智能是一个强大的工具。例如,它被用于创建不涉及隐私问题的医疗数据集;帮助设计药物分子;改善科学论文和软件。深度伪造正在被调查用于视频团体治疗中匿名参与者;创建更具说服力的医生或教师定制头像以吸引观众;或在社会科学研究中改善控制条件2。“我更有信心而不是担心,”桑达说。 “我认为作为一种技术,它具有变革性。”

但是随着滥用的幽灵不断出现,研究人员和伦理学家试图为人工智能制定规则,包括2018年的《蒙特利尔人工智能负责任发展宣言》和2019年经济合作与发展组织发布的《人工智能建议》。一个名为人工智能合作伙伴关系的倡议是非营利组织,包括主要行业合作伙伴,促进最佳实践的对话 - 尽管有些观察者和参与者质疑它是否产生了任何影响。

所有人都主张在合成内容中透明和披露的原则。公司正在采纳这些原则:例如,今年3月,TikTok更新了社区指南,要求创作者必须披露在任何看似真实的情况下使用AI的情况。7月份,包括Meta、微软、谷歌、OpenAI和亚马逊在内的七大领先科技公司向白宫做出了自愿承诺,以标记由他们生成的内容。9月份,谷歌宣布从11月中旬开始,任何用于政治广告的AI生成内容都必须在其平台上声明,包括YouTube。

一种标记合成图像的方法是通过以对眼睛不可察觉但对分析明显的特定方式改变像素来给图像添加水印。例如,调整每个第n个像素的颜色值使其为偶数,可以创建一个水印——但是一个非常简单的水印,几乎可以在任何图像操作后消失,比如应用颜色滤镜。一些人批评某些水印容易被删除。但是,例如,可以在图像的一侧插入从深到浅的阴影图案,并将其叠加在几个类似的图案之上,这样就无法通过单独调整像素来擦除它。据法里德说,这些水印可能难以(但并非不可能)删除。今年8月,谷歌发布了一个名为SynthID的合成图像水印,但没有透露其工作原理的细节;目前还不清楚它的可靠性如何,法里德说。

与添加水印相伴的想法是使用安全的源信息对文件的元数据进行标记。对于摄影来说,这种系统从拍摄照片时开始工作,即相机设备上的软件确保图像的GPS和时间戳是合法的,例如,图像不是另一张照片的照片。保险承保人使用此类系统来验证资产和损坏的照片,新闻机构路透社已经试用了验证技术来验证乌克兰战争的照片。

2022年,将技术和出版行业的主要团体召集在一起的联合内容源和真实性联盟(C2PA)发布了一套技术规范的第一个版本,说明了系统应该如何跟踪合成和真实图像的源信息。现在有许多符合C2PA标准的嵌入、跟踪和验证源数据的工具可供选择,许多公司的承诺——如微软的承诺——表示他们将遵循C2PA指导方针。“C2PA将非常重要;它将有所帮助,”巴西坎皮纳斯大学人工智能研究员安德森·罗查说。

跟踪图像源的系统应该成为减少可疑文件数量的工作重点,法里德说,他是C2PA指导委员会的成员,也是加利福尼亚州圣迭戈市Truepic公司的付费顾问,该公司销售跟踪真实照片和视频的软件。但这依赖于“好人”加入C2PA这样的计划,他说:“事情会从裂缝中溜走。”这使得检测器成为一种很好的补充工具。

学术实验室和企业已经生产了许多基于AI的分类器。这些学习能够区分AI生成的媒体和真实照片的模式,许多系统报告称它们可以在90%以上的时间内发现假货,同时错误地将真实图像识别为假货的时间仅为1%或更少。但是这些系统往往可以被击败。法里德说,不良行为者可以调整图像,使得检测器更有可能出错而不是正确。

基于AI的工具可以与其他依赖于人类洞察的方法相结合,以区分真实和虚假。法里德寻找诸如不符合物理规律的视角线索等线索。其他迹象则更为微妙。他和他的同事发现,例如,由StyleGAN生成器制作的面部轮廓倾向于将眼睛放在照片中的确切位置,这为判断哪些面孔是虚假提供了线索。检测器可以赋予复杂的算法,例如,能够读取照片中某个地方的时钟,并检查图像中的光线是否与记录的时间相匹配。科技公司英特尔的FakeCatcher通过观察由于血流波动在人脸上产生的预期颜色变化来分析视频。一些检测器寻找由相机的光传感器产生的独特的噪声模式,这些模式到目前为止还没有很好地被AI复制。

前总统奥巴马的一段虚假视频使用了面部映射技术,使人说出从未说过的话。专家担心深度虚假视频的影响,比如这段奥巴马的视频。

制作者和检测者的对抗非常激烈。法里德回忆起他的前学生、现任职于纽约州立大学布法罗分校的刘思伟(Siwei Lyu)的一篇论文,论文强调了一些AI视频中的人物眨眼速率不同5。他说,生成器在几周内就解决了这个问题。因此,尽管法里德的实验室发表了其绝大部分工作,但仅根据请求向学者提供代码。阿卜杜勒-阿马尔吉德也采取了类似的做法。“如果我们把我们的工具公之于众,人们会创造出更复杂的生成方法,”他说。

已经有几个具有公共用户界面的检测服务涌现了出来,许多学术实验室也在关注这个问题,包括纽约罗切斯特理工学院的DeFake项目和纽约州立大学布法罗分校的DeepFake-o-meter。美国国防高级研究计划局(DARPA)在2021年启动了其Semantic Forensics(SemaFor)项目,其广泛的职责是揭示任何生成文件背后的谁、什么、为什么和如何。该项目负责人威尔·科尔维(Wi Wil Corvey)表示,一个由近100名学术和公司研究人员组成的团队已经在SemaFor下合作创造了超过150种分析方法。大部分是可以在单独使用或一起使用的检测算法。

由于生成器和检测器的数量庞大,而且每个案例都不同,报告的准确性率波动很大。它们之间的军备竞赛意味着情况不断变化。但对于许多媒体类型而言,目前的成功率很低。对于生成文本,今年对14个检测工具的审查发现它们都是“既不准确也不可靠”6。对于视频,2020年的一项高调比赛的胜者只准确地识别了大约65%的内容3(另请参阅go.nature.com/3jvevoc)。对于图像来说,科尔维说如果生成器是众所周知的,那么检测器可以轻松地达到95%以上的准确率;但如果生成器是新的或未知的,成功率通常会大幅降低。科尔维说,对同一图像使用多个检测器可以提高成功率。

他还说,检测某物是否合成只是谜团的一部分:随着越来越多的用户依赖AI来调整他们的内容,更重要的问题不是‘这个东西有多少是合成的?’而是‘为什么要制作这个?’为此,SemaFor的重要工作之一是通过将媒体归因于创作者并描述其含义来确定伪造背后的意图。DARPA的一个并行项目,影响运动意识与意义构建(INCAS),正在努力开发自动化工具来检测可能或可能不受AI伪造支持的大范围误导信息运动的信号。

SemaFor项目已经进入第三阶段,也是最终阶段,科尔维正专注于接触社交媒体等潜在的用户。“我们已经与包括谷歌在内的多家公司进行了接触。据我们了解,目前没有一家在持续运行我们的算法,”他说。Meta与密歇根州立大学East Lansing分校的研究人员合作开发检测器,但没有透露可能如何使用它们。法里德与以就业为导向的平台LinkedIn合作,该平台使用基于AI的检测器来帮助清除虚假账户所使用的合成面孔。

阿卜杜-阿尔马吉德赞成社交媒体在其网站上的所有图像上运行检测器,或许还会对被标记为高度可能是假的照片发布警告标签。但几年前他与一家未具名的公司讨论过这个问题,但没有成功。“我告诉一个社交网络平台,拿我的软件用吧,免费拿去用。他们说,如果你不能告诉我如何赚钱,我们就不在乎,”阿卜杜-阿尔马吉德说。然而,法里德认为自动化检测器并不适合这种用途:即使一个准确率达到99%的工具,也可能会在一个样本中出错,他认为这会完全削弱公众的信心。法里德认为,检测应该针对具体案例的密集、人力主导的调查,而不是试图监管整个互联网。

许多人认为,出版商和社交媒体等公司将需要立法推动他们采取负责任的行为。6月,欧洲议会通过了一项法律草案,将严格监管高风险的人工智能应用,并强制披露由此类工具生成的内容。“全世界都在关注,因为欧盟在这个问题上处于领先地位,”南丁格尔说。但专家们对该法案的优点和是否可能抑制创新意见不一。在美国,有几项人工智能法案正在审议中,包括一项旨在防止亲密照片的深度伪造和一项关于人工智能在政治广告中使用的法案,但都没有确定通过。

专家们在这一点上达成了共识:提高技术素养将有助于防止社会和民主被虚假信息淹没。“我们需要宣传,让人们了解正在发生的事情,”罗查说。“当他们了解到这一点时,他们可以采取行动。他们可以要求在学校进行教育。”

法里德表示,即使我们拥有所有技术和社交工具,阻止或捕获所有伪造品的战争也是必败的。“但这没关系,因为即使失败,我也会把这个任务从普通人手中夺走。”然后,就像假钞一样,仍然有可能使用生成式AI假造品欺骗世界——但要难得多。

https://blog.sciencenet.cn/blog-41174-1404114.html

上一篇:解决论文可重复性难题的思路

下一篇:经济有效存储氢气的分子海绵