博文

预印本是有效的学术成果吗?如何让预印本在学术评估中发挥效用?| 预印本知多少(十三)  精选

精选

||

一项针对中国科研人员对预印本平台认知和使用情况的调查发现,有47.25%的学者担心预印本平台发布的成果无法用于学术评价[1]。由于缺少有效的学术评价机制支持,科研人员在参与预印本学术交流方面的积极性受到了一定程度的影响。本文旨在探讨预印本在学术评价体系中的应用,并为大家介绍学术界关于将预印本纳入学术评价体系的行动建议。

欢迎浏览Preprints.org官网了解更多有关平台和预印本的信息:

https://www.preprints.org/?mtm_campaign=sciencenet-post

本文首发于“PreprintsOrg 预印本”公众号:

https://mp.weixin.qq.com/s/6W9BxTnNoDF1kB_rKEjovg

01 预印本作为有效的学术成果

在之前的文章中,我们探讨了资助机构和高校对预印本发布所持的积极态度。同时,它们也在积极尝试和接纳将预印本视为评估科研成就的有效依据。

以研究卓越框架(REF)为例,该计划旨在评估英国高等教育机构科研成果的卓越性和影响力,其评分结果直接关系到每年约20亿英镑的国家研究资金的分配[2]。根据REF2021和REF2029的政策,接受出版版本的预印本论文可作为有效成果提交[2,3]。这一规定旨在认可那些未能及时在期刊上发表,但已提前以预印本形式发布的文章。同时REF承诺,其评估小组将根据“原创性、重要性和严谨性”来公平评价所有研究成果,不受出版方式、地点或出版社的影响[2]。

另外,诸如英国医学研究理事会、欧洲研究委员会、人类前沿科学计划等资助机构也在其政策中表明,申请材料中可以包含或引用注册了DOI的预印本文章。同样,诸如美国加州大学、中国山东大学李昂课题组等一些国内外高校也在积极接纳预印本,允许学者将其作为学术成就的一部分纳入申请材料中,用于申请职位、学位和晋升。

推荐阅读:

除了机构和高校外,包括Google Scholar、 ORCID、SciProfiles在内的学者档案类型的平台也会把预印本视作学者的学术成果,列在学者资料页。其中Google Scholar还会收录和展示预印本的引用情况,进一步彰显预印本的学术价值。

尽管不少利益相关方已尝试将预印本纳入学术成就评价体系,但仍一些学者指出,直接评估预印本质量在某些情况下可能面临困难,例如评估时间有限,评估者无法仔细阅读所有的申请论文,或评估者不是申请者研究领域的专家等[4]。因此,依赖期刊排名和影响因子进行初步筛选仍然是业界一种常见做法。但这种基于期刊的评估可能带来误导和偏见,且存在一定局限性[4,5]。当前,如何优化并改革学术评估模式,已成为亟待解决的新课题。

02 为什么要构建新的评估模式?该如何评估预印本?

在前文中,我们指出了基于期刊的学术评价可能带来的误导和偏见。支持者指出,期刊影响因子(JIF)最初是作为图书馆员挑选期刊的辅助工具,并非衡量文章质量的标准,而且JIF容易受到自我引用和综述文章的影响,因此不应成为学术追求的终极目标[6]。

另有研究表明,基于引用次数的指标并不能完全反映单篇文章的质量,它们通常在评估集合研究成果(例如学者、部门、机构等的作品集合)时更为准确[7]。也就是基于引用次数的指标并不普遍适用于所有情况。

与此同时,全球科学正迅速向开放获取转型,学术出版和研究成果传播形式变得更加多样化,科学交流不再局限于传统期刊发表或学术圈内的封闭交流。在此背景下,各大机构和高校也纷纷设立了开放获取成果发布的目标。

鉴于上述原因,学术界及更广泛的社区愈发认识到,需要接纳诸如预印本在内的多样化研究产出,以及开发更加公平和多元的评估方式,包括开发新型评价指标[5],以及寻求其他途径来确保研究质量[4]。

这一观点也得到了国际性倡议的支持——2012年旧金山研究评估宣言(DORA)提出,科学家的质量不应仅由在竞争期刊上发表文章来定义。DORA建议考虑包括政策和实践影响在内的多方面影响,并从期刊指标转向评估科学内容本身,同时考虑数据集、预印本等其他学术产出[6]。

在此,我们整理了学术界关于将预印本纳入学术评价体系的行动建议,以展现业界人士的态度和当前的发展趋势。

(1) 开发补充性评估指标/方法

大连理工大学的研究人员提出了Mendeley读者数这一补充计量指标,旨在弥补基于引用量的传统评估方法的不足[8]。在对图书情报领域的预印本影响力进行研究时,他们发现Mendeley读者数与论文引用量之间存在显著的相关性。相较于引用次数,Mendeley读者数能更全面地反映论文的影响范围,因此可以作为评估学术论文早期影响力的辅助工具。此外,研究人员还强调,发展此类补充计量指标对于推动学术资源的开放获取具有积极影响。

该研究是国家自然科学基金面上项目“基于证据链的学术影响力定量评价方法研究”(71771205)的成果之一。

这一论点得到了另一项实证研究的支持[9]——有学者分析了补充计量指标(Altmetrics)与REF2021论文质量评分之间的相关性,结果显示,在多数学科领域中,Mendeley读者数是最佳的Altmetrics指标。尽管它无法取代引用量指标,但在引用时间窗口较短、无法充分反映引用情况时,采用Mendeley读者数作为评估早期影响力或质量的指标,是一个合理的替代方案。

随着预印本和其他多样化科研产出的增加,学术界对于社交媒体关注、文章层面和作者层面等新类型指标的需求也在增长。目前,众多预印本平台采用了一系列量化指标来衡量预印本文章的影响力,以此补充研究的受欢迎程度和网络讨论度等方面的信息。

例如,SSRN提供了包括下载量、摘要浏览次数以及论文、作者和组织排名在内的机构级数据报告[10]。PeerJ提供了涵盖社交媒体推荐和主要搜索引擎、书签、链接及电子邮件提醒的文章级别指标[11]。

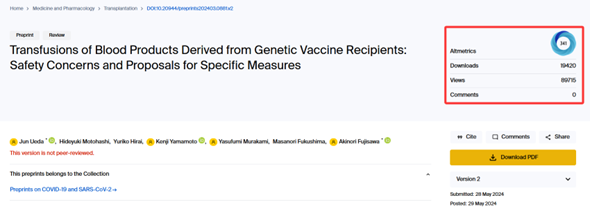

Preprints.org则展示了预印本文章的阅读量、下载量、公开评论及Altmetrics关注度分数[12]。Altmetrics关注度分数反映了基于网络的媒体和公众对文章的提及表现。

图1:Preprints.org预印本平台文章示例

除了量化指标之外,亦有学者提出将定性方法纳入综合性评估指标或评估框架之中,用以评估研究项目的社会价值,比如devmetrics(发展指标)[13]和Flows of Knowledge(知识流动)评估法[14]。

这些定性方法,包括半结构化访谈和焦点小组,能够评估研究对非学术领域的影响,如对社会和政策的贡献,以及在可持续发展方面的作用。它们为非正式出版物或在传统指标中表现不突出的特定研究提供了一种有效的评估途径。

(2) 控制预印本质量

除了开发补充性指标或构建新的评估方法外,对预印本的质量进行控制,也能让评估者更愿意接纳预印本作为有效的学术成果。

学者Naomi C. Penfold和Jessica K. Polka提出了三种假设性流程,以确保预印本的质量,并预测这些流程在未来十年内有望实现,从而使预印本在研究评估中发挥更大的效用[4]。

过程一强调科研透明度。为保证研究能够按需接受严格审查,有必要公开透明地披露研究方法、数据和代码等信息。作者建议可以开发一项服务来检查研究资料的完整性和可获取性。这将使评估者在确信信息无遗漏的情况下,更愿意投入时间进行评估。

过程二注重方法严谨性检查。该过程旨在开发一项服务,用以评估预印本是否遵循学术界的最佳实践,包括对研究代码、数据和图像的可靠性进行审核,并提供透明评审报告及专家反馈。这对评估者,尤其是非相关领域专家,是有力的质量证明。

过程三突出社区作用。其过程类似于传统期刊出版的覆盖期刊(Overlay Journals),由专家或学术社区精选优质预印本论文,形成特别合集。论文若被纳入此类合集,即表明受到社区关注和认可。这一服务不仅为研究的可靠性背书,还能迅速吸引普通读者的关注和反馈。

此外,当前还有一些机构和出版平台鼓励并推行预印本开放评审这一开放科学实践[15,16]。通过公开透明的评审,有望消除传统同行评审中可能存在的偏见,同时筛选出高质量的预印本论文。在这个过程中,业内学者和公众也可以深入了解研究的进展,并及时与作者交流合作,发表自己的见解。

经过开放式评审的预印本论文虽然没有影响因子等传统指标,但其质量也获得了同行的把控,这对于学术成就评估者在进行评估时而言,同样具有参考价值。

作为全球领先的预印本平台,Preprints.org始终紧跟学术界的步伐,积极采纳开放获取的政策和建议。在Preprints.org的作者指南中,我们强烈建议作者公开与稿件相关的所有数据,并上传文章的补充材料,以便读者审阅,从而提高科学研究的透明度。

图2:Preprints.org鼓励作者提供与稿件相关的所有数据

此外,Preprints.org设有开放的评论区,允许任何人分享对研究的看法,并披露潜在的利益冲突,这不仅保障了评论的公正性,还有助于作者改进文章。

图3:Preprints.org预印本平台上的评论示例

未来,Preprints.org将继续关注业界发展,致力于为广大学者提供更加优质的预印本服务,不断优化评论与反馈机制,全方位提升作者与读者的服务体验。

总而言之,随着全球科学正迅速向开放获取转型,预印本发布正日益受到重视。我们有理由相信,将预印本纳入学术成就评估体系,并着手构建预印本评估框架,将是推动学术交流和科研评价改革的重要一步。此举不仅能更全面、公正地反映学者的贡献,还能鼓励更多研究人员积极参与开放科学运动,助力实现机构和高校设定的开放获取目标。在此,我们也呼吁所有利益相关方参与这一进程,借鉴现有实例和评估框架,共同支持建立一个更透明、更包容的科研环境。

参考文献:

[1] 刘静羽; 刘敬仪; 杨恒; 等 . 我国科研人员对预印本平台的认知与使用研究. 图书情报工作 2023, 67, 26-48. https://doi.org/10.13266/j.issn.0252-3116.2023.05.003

[2] Preprints are valid research outputs for REF2021. Available online: https://asapbio.org/preprints-valid-for-ref2021 (accessed on 16 December 2024)

[3] REF 2029 Open Access Policy. Available online: https://2029.ref.ac.uk/guidance/ref-2029-open-access-policy/ (accessed on 19 December 2024)

[4] What do preprints need to be more useful in evaluation?. Available online: https://sfdora.org/2019/10/07/what-do-preprints-need-to-be-more-useful-in-evaluation/ (accessed on 16 December 2024)

[5] Balaji, B.; Dhanamjaya, M. Preprints in Scholarly Communication: Re-Imagining Metrics and Infrastructures. Publications 2019, 7, 6. https://doi.org/10.3390/publications7010006

[6] Hedrick, S.; Yang, J.; Rong, Y. Promotion and Tenure for Medical Physicists Should Be Based on Article Specific Measures and Not on Journal Impact Factor. Journal of Applied Clinical Medical Physics 2024. https://doi.org/10.1002/acm2.14537

[7] Taylor, M. Evaluating Open Access Advantages for Citations and Altmetrics (2011-21): A Dynamic and Evolving Relationship. arXiv 2024. https://doi.org/10.48550/arXiv.2406.10535

[8] 陈悦; 王智琦; 刘则渊; 等. 多指标视角下的图书情报类预印本影响力评价. 情报学报 2019, 38, 342–353. https://doi.org/10.3772/j.issn.1000-0135.2019.04.002

[9] Thelwall, M.; Kousha, K.; Abdoli, M.; Stuart, E.; Makita, M.; Wilson, P.; Levitt, J. Do Altmetric Scores Reflect Article Quality? Evidence from the UK Research Excellence Framework 2021. Journal of the Association for Information Science and Technology 2023, 74, 582–593. https://doi.org/10.1002/asi.24751

[10] SSRN Homepage. Available online: https://www.ssrn.com/index.cfm/en/ (accessed on 24 December 2024)

[11] PeerJ Homepage. Available online: https://peerj.com/ (accessed on 24 December 2024)

[12] Preprints.org - The Multidisciplinary Preprint Platform. Available online: https://www.preprints.org/ (accessed on 24 December 2024)

[13] Arocena, R.; Göransson, B.; Sutz, J. Towards Making Research Evaluation More Compatible with Developmental Goals. Science and Public Policy 2018, 46, 210–218. https://doi.org/10.1093/scipol/scy051

[14] Smit J P; Hessels L K. The production of scientific and societal value in research evaluation: a review of societal impact assessment methods. Research Evaluation 2021, 30, 323-335. https://doi.org/10.1093/reseval/rvab002

[15] Chiarelli, A.; Cox, E.; Johnson, R.; Waltman, L.; Kaltenbrunner, W.; Brasil, A.; Reyes Elizondo, A.; Pinfield, S. “Towards Responsible Publishing”: Findings from a global stakeholder consultation. Zenodo 2024. https://doi.org/10.5281/zenodo.11243942

[16] F1000research. How it Works. Available online: https://f1000research.com/about (accessed on 24 December 2024)

https://blog.sciencenet.cn/blog-3516770-1478674.html

上一篇:Veterinary Sciences:新型猪细小病毒流行特征及其对母猪繁殖的影响——哥伦比亚猪群调查

下一篇:色彩科研 | 科研人必看!那抹“绿”让论文图表颜值爆表