博文

基于深度学习初始位姿估计的机器人摄影测量视点规划

|

引用本文

姜涛, 崔海华, 程筱胜, 田威. 基于深度学习初始位姿估计的机器人摄影测量视点规划. 自动化学报, 2023, 49(11): 2326−2337 doi: 10.16383/j.aas.c200255

Jiang Tao, Cui Hai-Hua, Cheng Xiao-Sheng, Tian Wei. Viewpoint planning for robot photogrammetry based on initial pose estimation via deep learning. Acta Automatica Sinica, 2023, 49(11): 2326−2337 doi: 10.16383/j.aas.c200255

http://www.aas.net.cn/cn/article/doi/10.16383/j.aas.c200255

关键词

摄影测量,机器人,深度学习,视点规划,可见性矩阵,熵权法

摘要

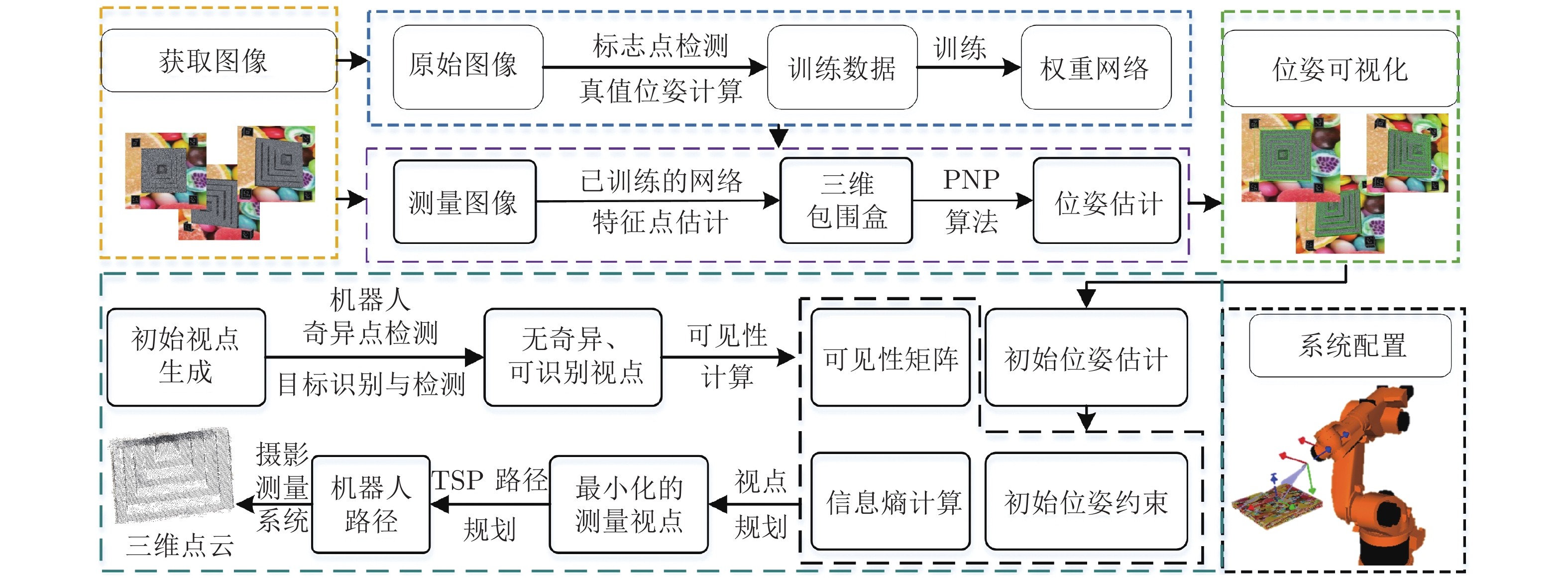

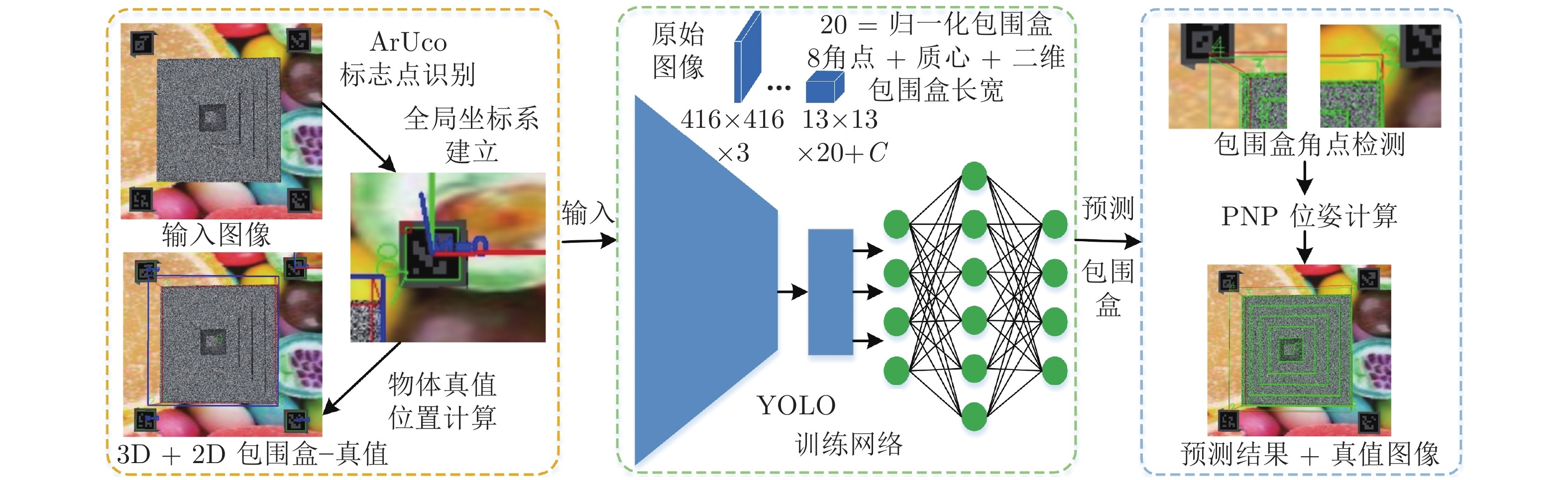

针对机器人摄影测量中离线规划受初始位姿标定影响的问题, 提出融合初始位姿估计的机器人摄影测量系统视点规划方法. 首先构建基于YOLO (You only look once) 的深度学习网络估计被测对象3D包围盒, 利用PNP (Perspective-N-point)算法快速求解对象姿态; 然后随机生成机器人无奇异无碰撞的视点, 基于相机成像的2D-3D正逆性映射, 根据深度原则计算每个视角下目标可见性矩阵; 最后, 引入熵权法, 以最小化重建信息熵为目标建立优化模型, 并基于旅行商问题(Travelling saleman problem, TSP)模型规划机器人路径. 结果表明, 利用深度学习估计的平移误差低于5 mm, 角度误差低于2°. 考虑熵权的视点规划方法提高了摄影测量质量, 融合深度学习初始姿态的摄影测量系统提高了重建效率. 利用本算法对典型零件进行摄影测量质量和效率的验证, 均获得优异的位姿估计和重建效果. 提出的算法适用于实际工程应用, 尤其是快速稀疏摄影重建, 促进了工业摄影测量速度与自动化程度提升.

文章导读

传统的摄影测量技术是利用单相机从多个角度拍摄大量图片进行物体三维重建的技术[1], 在机器人系统[2-3]、遥感测绘、制造测量[4]等领域应用广泛. 近年来, 利用机器人进行测量检测的研究和应用逐渐增加, 视觉与机器人系统的集成提升了视觉测量与检测的效率和自动化水平. 然而, 机器人摄影测量系统中, 机器人相对测量对象初始位姿需要标定和人工输入, 导致机器人离线编程受到实际测量环境影响.

机器人摄影测量系统的核心问题是安装视觉系统后, 具有可视能力的机器人视点规划与路径规划问题. Kinnell等[7]对机器人三维视觉系统框架做出了详细论述. Kwon等[8]研究了机器人扫描系统, 提出重扫描策略, 缩短了扫描时间, 增强了机器人检测的稳定性. Raffaeli等[9]提出基于理论数模的机器人扫描路径离线编程算法, 但是离线程序依赖于在线校准. Li等[10]提出基于邻域搜索方法来确定机器人二维扫描的方向, 但其路径规划不连续, 需要后期多组测量数据的再次融合. 为实现以最小的拍摄视点获得最丰富的重建信息, 需要依据视点可见性对拍摄视点进行优化[11]. “Generate-test”方法在基于模型的视点规划中得到了广泛的应用[12]. 它生成大量的候选视点, 并计算每个视点下的可见矩阵. 然后将覆盖问题转化为可见矩阵的最优选择问题[12]. Jing等[13]采用迭代随机抽样和概率势场方法以非确定性方式生成候选视点. 在较高的覆盖率下, 保证了较好的视点规划效果. 然后, Jing等[14]将视点规划和路径规划结合为一个单一的规划问题, 取得较好的全局最优效果. 在实际测量中, 机器人视觉系统必须确定被测对象相对于自身的实际位姿, 并以此为初始姿态进行扫描路径的规划. 基于视觉的目标位姿测量方法主要有PNP (Perspective-N-point)[15]方法和三维刚体变换法[16], 这些方法需要精确已知被测对象特征, 提取并重建出必要的特征要素进行位姿计算, 虽然位姿计算精度高, 但是在可变化的环境中特征提取不稳定, 容易产生误差. 深度学习技术在位姿估计方面具有环境适应性强、自动化程度高等优势. 近年来, 利用卷积神经网络(Convolutional neural network, CNN)进行位姿估计的研究发展迅速[17-19]. PoseNet[20]网络直接利用CNN从单幅RGB图像中估计相机6D姿态, 但是其将旋转分量和平移分量单独输出, 训练过程必须调整参数来平衡两个分量的损失. 为避免这个问题, PoseCNN[21]网络则直接将位姿误差作为损失函数而更加适应于位姿优化. 文献[22-23]中, CNN没有直接用于位姿估计, 而是通过估计特征点然后计算三维姿态的方法, 提高了位姿估计的速度和精度. 二维物体识别与预测主要有Faster R-CNN (Faster region-CNN)、YOLO (You only look once)、SSD (Single shot multibox detector)[22]等网络结构, 且均有良好的预测效果. Tekin等[17]和Rad等[23]分别利用YOLO和SSD提出了基于单幅图像的位姿估计模型, 提升了位姿估计速度.

可见, 利用深度学习进行位姿估计, 并与机器人视点规划相结合, 是机器人自动化高效率摄影测量的新的方式. 本文针对机器人摄影测量系统中初始位姿估计、机器人扫描路径规划两个主要问题, 研究提升机器人摄影测量效率和自动化程度的新方法. 提出融合深度学习位姿估计的机器人摄影测量系统视点规划策略(第2节). 主要贡献在于: 1)基于YOLO模型与PNP算法实现了单相机快速位姿估计, 替代传统的初始位姿现场校准的工作(第2.1节); 2)提出基于相机成像2D-3D正逆性映射的被测模型可见性矩阵估计(第2.2节); 3)提出基于初始位姿约束和熵权法的机器人摄影测量视点规划和路径规划方法(第2.3节). 利用几种具有典型特征的零件进行实验验证, 获得了优异的位姿估计效果和摄影重建结果(第3节).

图 1 机器人摄影测量系统简图

图 2 融合初始位姿估计的视点规划策略

图 3 深度学习实现单幅图像位姿估计流程

提出一种基于深度学习初始位姿估计的机器人摄影测量系统视点规划方法, 实现了利用单相机快速位姿估计, 平移精度优于5 mm, 角度精度优于2°. 提出基于相机成像映射的可见性矩阵计算. 利用所提的视点规划策略提升了摄影测量重建的效率. 对几种具有典型特征的零件进行摄影测量, 本文方法在位姿估计、重建效率方面均表现优异, 重建质量因初始位姿约束有所下降, 故适用于快速稀疏摄影重建. 本文方法促进了机器人摄影测量系统现场测量的智能性、灵活性和自动化程度, 对工业摄影测量具有重要的推进意义.

本文网络为开源网络, 为扩展网络应用价值, 公开本文中圆柱体模型的数据集供同行使用. 本文所使用的模型均来自英国诺丁汉大学制造测量团队.

作者简介

姜涛

宿迁学院机电工程学院副教授. 主要研究方向为光学精密测量, 智能制造系统中的视觉测量技术及应用. E-mail: jtmaster1@163.com

崔海华

南京航空航天大学机电学院教授. 主要研究方向为光学精密测量. 本文通信作者. E-mail: cuihh@nuaa.edu.cn

程筱胜

南京航空航天大学机电学院教授. 主要研究方向为数字化技术与装备. E-mail: smcadme@nuaa.edu.cn

田威

南京航空航天大学机电学院教授. 主要研究方向为机器人装配技术与装备. E-mail: tw_nj@nuaa.edu.cn

https://blog.sciencenet.cn/blog-3291369-1411851.html

上一篇:基于网络演算的时间敏感网络时延上界分析模型研究

下一篇:【当期目录】IEEE/CAA JAS第10卷第11期