博文

[转载]通过变分贝叶斯方法实现深度神经网络的块项分解

||

通过变分贝叶斯方法实现深度神经网络的块项分解

刘婕1,杨帆1,史长宏1,吴澄2,刘微容1

(1. 兰州理工大学 自动化与电气工程学院,兰州 730050;2. 苏州大学 信号与控制工程系,江苏苏州 215011)

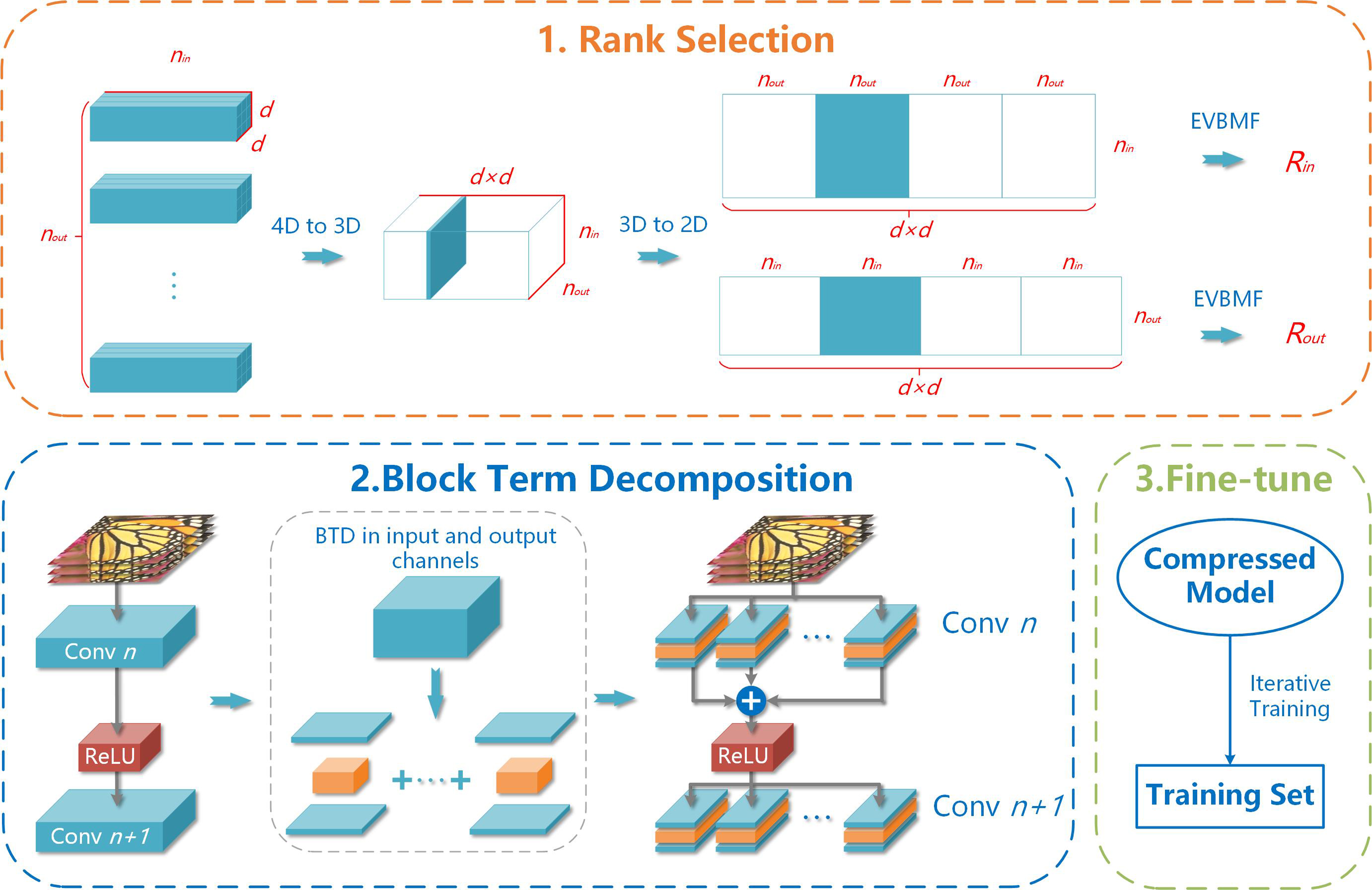

摘要:张量分解能够有效降低深度神经网络(DNN)中的冗余参数和浮点运算量(FLOPs);参数与计算复杂度较低的深度神经网络易于在边缘设备上部署。作为CANDECOMP/PARAFAC分解与Tucker分解结合的块项分解(BTD)具有更强的泛化性能,但需要同时配置Tucker张量数量与各核心张量维度,因此秩的调试配置更加困难。针对BTD分解秩配置困难的问题,本文提出一种基于变分贝叶斯的深度神经网络块项分解方法(BTD-VB);该方法主要由选取网络层参数张量秩、BTD分解压缩网络参数和微调压缩模型三部分构成。通过引入经验变分贝叶斯矩阵分解的全局解析解,BTD-VB自动预估各网络层参数张量秩的范围。相关实验结果表明:相较于现有先进方法,提出的BTD-VB在保证压缩性能的同时实现了更高的压缩率。

关键词:张量分解,低秩,深度神经网络,网络压缩

扫二维码浏览全文

Cite this article

Liu, J., Yang, F., Shi, C. et al. Block Term Decomposition of Deep Neural Networks by Variational Bayesian. J. Shanghai Jiaotong Univ. (Sci.) (2025). https://doi.org/10.1007/s12204-025-2873-x

https://blog.sciencenet.cn/blog-45888-1513190.html

上一篇:[转载]结合小波域判别器的U-Net模型用于视网膜血管分割

下一篇:[转载]MCMTNet:一种轻量级双流架构的高精度 WiFi 人体活动识别模型