博文

AI让抄袭变的更隐蔽,科学界如何应对?  精选

精选

|

今年,从哈佛大学校长因指控而辞职的风波,到二月份发现的同行评审报告中的抄袭文本,学术界因抄袭事件而动荡不安。但一个更大的问题在学术写作领域中浮现。快速兴起的生成式人工智能(AI)工具——这些工具能根据提示创作文本——引发了关于这是否构成抄袭以及在何种情况下允许使用的问题。“AI的使用存在整个光谱,从完全由人类撰写到完全由AI撰写——而在中间,有这片广阔的困惑之地,”路易斯安那州新奥尔良的版权和抄袭顾问乔纳森·贝利说。

AI is complicating plagiarism. How should scientists respond? (nature.com)

像ChatGPT这样的生成式AI工具基于所谓的大型语言模型(LLMs),可以节省时间,提高清晰度并减少语言障碍。许多研究人员现在认为,在某些情况下它们是可以使用的,并且应该全面披露其使用情况。但这些工具使得围绕不当使用他人作品的已经紧张的辩论变得更加复杂。LLMs通过消化大量之前发表的写作来生成文本。因此,如果研究人员将机器的工作当作自己的,或者机器生成的文本与某人的工作非常接近但没有引用来源,那么使用这些工具可能会导致类似于抄袭的情况。这些工具还可以用来隐藏故意的抄袭文本,而且任何使用它们都很难被发现。“定义我们实际上所说的学术不诚实或抄袭的含义,以及界限在哪里,将会非常、非常困难,”英国普利茅斯大学的生态学家皮特·科顿说。

在2023年对1600名研究人员的调查中,68%的受访者表示AI会使抄袭更容易也更难以检测。“每个人都担心其他人使用这些系统,也担心自己在该用的时候不用,”柏林应用科学大学的抄袭专家德博拉·韦伯-沃尔夫说。“每个人都对此感到焦虑。”

抄袭遇上AI

美国研究诚信办公室将抄袭定义为“未经适当引用就采用另一个人的想法、过程、结果或文字”,这是一个熟悉的问题。2015年的估计显示,有1.7%的科学家承认有过抄袭行为,而且30%的人知道有同事犯过此罪。

LLMs可能会使情况变得更糟。如果某人先请LLM对人写的文本进行改写,那么有意的抄袭行为很容易被掩盖。加拿大温哥华不列颠哥伦比亚大学的计算机科学家和语言学家穆罕默德·阿卜杜勒-马吉德说,这些工具可以被提示以复杂的方式改写,比如模仿学术期刊的风格。

一个中心问题是,使用完全由机器而非人类编写的未注明出处的内容是否算作抄袭。许多研究人员认为并不一定如此。例如,包括大学和个人在内的欧洲学术诚信网络将禁止或未声明使用AI工具写作定义为“未经授权的内容生成”,而不是作为抄袭本身。《对我来说,抄袭会有可归因于另一个可识别的人的东西,”韦伯-沃尔夫说。尽管有时生成式AI产生的文本与现有的人类编写内容看起来几乎一模一样,但它通常并不足够接近以被视为抄袭,她补充说。

然而,一些人认为生成式AI工具侵犯了版权。抄袭和版权侵犯都是不当使用他人作品的行为,而抄袭是违反学术伦理的,未经授权使用受版权保护的作品可能触犯法律。“这些AI系统是建立在数百万或数亿人的工作之上的,”密歇根大学安娜堡分校的计算机科学家拉达·米哈切说。

一些媒体公司和作者抗议他们所看到的AI对版权的侵犯。2023年12月,《纽约时报》对科技巨头微软和美国公司OpenAI提起了版权诉讼,后者是驱动聊天机器人ChatGPT的大型语言模型GPT-4背后的公司。该诉讼声称这两家公司复制并使用了该报的数百万篇文章来训练LLMs,现在这些LLMs与出版物的内容竞争。《纽约时报》在诉讼中包括了一些提示导致GPT-4几乎逐字复制报纸文章的几个段落的情况。

2月,OpenAI在联邦法院提交了一份动议,要求驳回诉讼的部分内容,辩称“ChatGPT绝不是《纽约时报》订阅的替代品”。微软的一位发言人表示,“合法开发的AI驱动工具应该被允许负责任地推进”,“它们也不是记者所扮演的关键角色的替代品”。

如果法院裁定未经允许就对文本进行AI训练确实是侵权,“那将对AI公司产生巨大震动”,贝利说。没有广泛的训练集,像ChatGPT这样的工具“就无法存在”,他说。

AI爆炸

不管是否称之为抄袭,自2022年11月ChatGPT发布以来,AI在学术写作中的使用已经爆炸性增长。

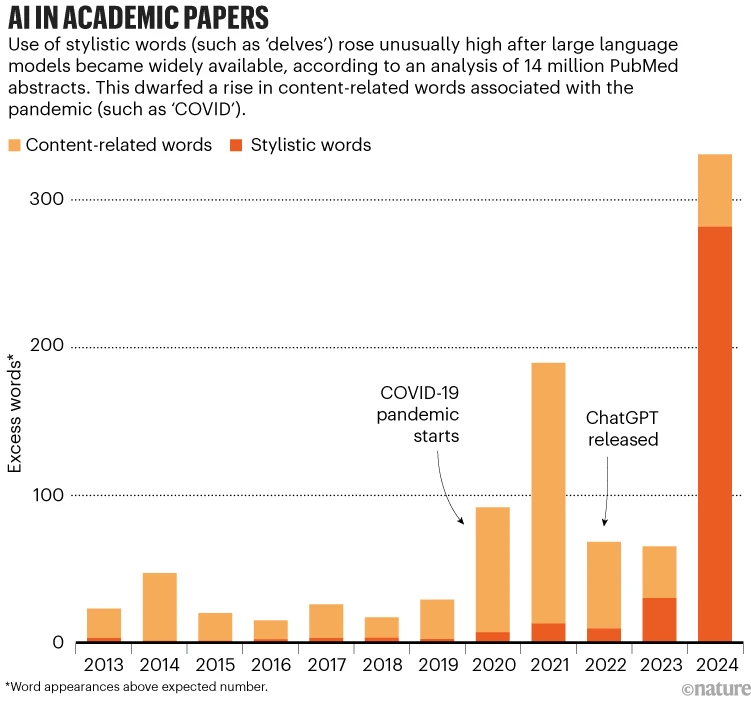

在7月更新的一份预印本中,研究人员估计,2024年前六个月至少有10%的生物医学论文摘要使用了LLMs进行写作——相当于每年150,000篇论文。这项研究由德国蒂宾根大学的数据科学家德米特里·科巴克领导,分析了从2010年到2024年6月在学术数据库PubMed上发表的1400万篇摘要。他们展示了LLMs的出现与风格词汇使用增加有关——如‘delves’、‘showcasing’和‘underscores’——然后利用这些不寻常的词模式来估计使用AI处理过的摘要比例(见‘学术论文中的AI’)。“LLMs写作助手的出现对科学文献产生了前所未有的影响,”他们写道。

科巴克及其同事发现,来自韩国等国的论文显示出比英语为主导语言的国家更频繁使用LLM的迹象。然而,科巴克说,后一组国家的作者可能同样经常使用这些工具,但使用方式更难被发现。科巴克预测,LLM的使用“肯定会继续增加”,并且“可能会更难被检测到”。

在学术写作中未披露软件使用并不是新鲜事。自2015年以来,法国图卢兹大学的计算机科学家吉约姆·卡巴纳克及其同事一直在揭露由一个名为SCIgen的软件生成的胡言乱语论文,以及包含由自动翻译或改写文本的软件创建的“扭曲短语”的论文。“即使在生成式AI出现之前,人们就有工具可以避开雷达探测,”卡巴纳克说。

而且,在学术写作中使用AI具有一定的价值。研究人员表示,它可以使文本和概念更加清晰,减少语言障碍,并为实验和思考腾出时间。利雅得沙特国王大学的信息科技研究员亨德·阿尔-哈利法说,在生成式AI工具可用之前,许多以英语为第二语言的同事在撰写论文时会挣扎。“现在,他们正专注于研究,并借助这些工具摆脱了写作的烦恼,”她说。

但是,关于何时使用AI构成抄袭或违反道德规范的问题仍然存在困惑。马里兰大学帕克分校的计算机科学家索希尔·菲齐说,使用LLM对现有论文的内容进行改写显然是抄袭。但是,如果透明地进行,使用LLM帮助表达想法——无论是基于详细提示生成文本,还是编辑草稿——都不应该受到惩罚。“我们应该允许人们利用大型语言模型来轻松、清晰地表达他们的想法,”菲齐说。

许多期刊现在有政策允许一定程度的LLM使用。最初禁止使用ChatGPT生成的文本后,《科学》杂志在2023年11月更新了其政策,称在撰写手稿时使用AI技术应全面披露——包括使用的系统和提示。它表示,作者应对准确性负责,并“确保没有抄袭”。《自然》杂志也表示,研究手稿的作者应在方法部分记录任何LLM的使用。(《自然》的新闻和特写团队与其期刊团队编辑独立。)

一项对100家大型学术出版社和100家高排名期刊的分析发现,截至2023年10月,24%的出版商和87%的期刊有关于生成式AI使用的指南。几乎所有提供指导的都表示,AI工具不能被列为作者,但对允许的AI使用类型和所需的披露程度的政策有所不同。韦伯-沃尔夫说,迫切需要更明确的关于学术写作中AI使用的指导方针。

阿卜杜勒-马吉德说,目前,LLM在撰写科学论文中的广泛使用受到其局限性的限制。用户需要创建详细的提示,描述受众、语言风格和研究领域。他说:“实际上,对于一个语言模型来说,给出你确切想要的内容是非常困难的。”

但是,开发者正在构建应用程序,使研究人员更容易生成专业的科学内容。阿卜杜勒-马吉德说,未来用户可能只需从下拉菜单中选择选项并按下按钮,就能从头开始生成整篇论文,而不必编写详细的提示。

随着LLM编写文本的迅速采用,涌现出大量旨在检测它的工具。尽管许多工具宣称准确率很高——在某些情况下超过90%——但研究表明,大多数工具并未达到其声称的效果。在去年12月发表的一项研究中,韦伯-沃尔夫及其同事评估了学术界广泛使用的14种AI检测工具。只有5种能准确地识别出70%或更多的文本是由AI还是人类编写的,没有任何一种得分超过80%。

当检测轻微编辑过的AI生成文本时——通过替换同义词和重新排列句子——检测器的准确率平均下降到了50%以下。作者写道,这种文本“几乎无法被当前的工具检测到”。其他研究显示,多次要求AI对文本进行改写会大大降低检测器的准确性。

AI检测器还有其他问题。一项研究显示,如果英语不是第一语言的人撰写的英文作品,检测器更有可能在将其误判为AI生成的文本。菲齐说,检测器无法可靠地区分完全由AI编写的文本和作者使用AI服务润色文本以提高语法和句子清晰度的情况。“区分这些情况将相当困难且不可靠——并可能导致大量误报,”他说。他补充说,被错误地指控使用AI“对那些学者或学生的声誉可能造成相当大的损害”。

AI的合法与非法使用之间的界限可能会进一步模糊。2023年3月,微软开始将其生成式AI工具集成到其应用程序中,包括Word、PowerPoint和Outlook。其一些版本的AI助手,称为Copilot,可以起草或编辑内容。6月,谷歌也开始将其生成式AI模型Gemini集成到Docs和Gmail等工具中。

英国普利茅斯玛琼大学的高等教育专家黛比·科顿说:“AI正在变得如此深入我们使用的一切中,我认为越来越难以知道你所做的事情是否受到了AI的影响。”“我认为它会以我们无法跟上的速度继续快速发展。”

https://blog.sciencenet.cn/blog-41174-1444489.html

上一篇:氢气缓解癌症放化疗副作用的研究【综述】

下一篇:感染能否导致阿尔茨海默病?