博文

为什么高质量数据是当下AI的真正门槛  精选

精选

|

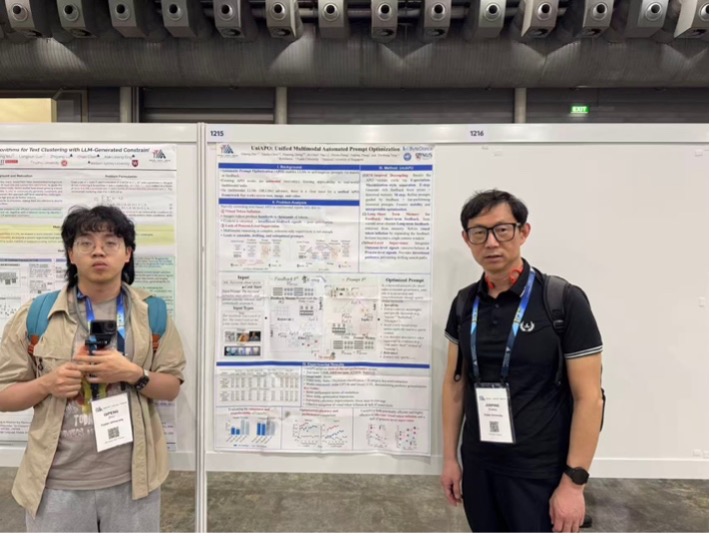

2026年1月20-27日,人工智能顶会AAAI在新加坡召开,我们组有论文接受,我也顺便去参加了。

图1: 在AAAI2026上发表的两篇文章的海报

本次会议的论文太多,日程安排也很紧凑,多数论文的口头报告时间只给了12分钟,感觉很难让人快速理解和消化。我选了几个我感兴趣的方向听了,包括气象预测、森林防火、多Agent协同、计算机视觉等,也听了些Keynotes,看了一些展板。一个比较强烈的感受是,如果这个会议放在国内开,把报告语言换成中文,效果可能更好,毕竟绝大部分报告人都来自中国。另一个感受是,虽然人工智能极其强大,但当人工智能学者讲报告时,显示出问题的时候,人工智能依然无法自动解决,需要人工来智能解决,可见人工智能仍然是任重道远。

图2: AAAI2026上听Keynotes报告,第四张图是报告显示出问题,正在人工修复中

7天会议期间,见了不少朋友,还顺便走访了以前合作过的量化投资公司,了解了公司层面对大模型、Agent Skills使用的情况。我也有幸参加了一个由AAAI组委会和几任主席参加的小规模晚宴,见到了人工智能第一个专家系统的发明人费肯鲍姆(他本人读的第一个音是Fai),并合影留念。晚宴中我也给他们介绍了我在中国做人工智能科普的情况。

图3:(左)去量化投资公司参观;(右)与费根鲍姆合影

~~~~~~~~

人工智能在科研、产业等领域形成如此大的突破,离不开近几年来大家常提的三板斧。巨量的高质量数据、参数巨多的深度模型(也包括大语言模型)以及强大的算力。

为什么需要巨量的高质量数据呢?两个原因,一是缩放定律(Scaling Law),因为目前的研究发现,要想让人工智能产生类似顿悟的质变,数据量得到10的22次方以上;二是训练模型的经验。传统机器学习观点认为,要将模型训练好,需要将数据集的规律按模型参数量呈指数级增加。而为了让其得到快速训练,具备并行计算能力的GPU显卡就变得不可或缺。

需要注意的是,训练好的意思是指什么?本质上是让模型根据输入参数形成与任务相关的准确预测。

为了实现好的预测,通常最有效的办法是监督学习,即预先给大量的数据进行标注。比如人脸识别,就将数据集里的每张人脸都加上张三、李四、王五的标签,它相当于给每种类别定义了一个原型概念。人工智能研究者从最初的人工海量标注,已经逐渐过渡到尽量不依赖人工的标注方式。但仍在想尽办法向标注或监督学习的方式对齐。即通过算法使学习的数据尽可能具有生成的标签。如自监督学习,是通过从数据本身来挖掘监督信息,以降低对人工标注的依赖。比如将视频里相同时间段的音频视频对视为正样本,不同时间段的视为负样本。而自监督学习中,目前比较热门的DINO-v2(Distillation without label),也是通过对未标注图像数据进行自蒸馏和多视角增强的表征学习,来从中提取监督信号,实现高质量的特征表示。所以,如何用好监督仍是目前人工智能的主流。

其次,要进行有效的类别分离,才能实现好的预测。人工智能有三种基本的策略。一是升维,即把输入数据的维度从小的维数通过复杂变换后升成高维,以获得好的可分性。比如目前的图像相关的输入,大多维度是在1024*1024分辨率或以下,否则内存或显存会爆。二是损失函数,多采用类似经典机器学习的线性判别分析(Linear Discriminant Analysis,简称LDA)的思路,来促使同一类别的数据要尽可能靠近,不同类别的数据要尽可能拉远。基于这一思路,深度学习时代常采用的损失函数是对比学习及其变体。第三个策略是提升整体对局部、前对后、多对一的预测能力,即Transformer及大语言模型常采用的自注意力、多头注意力、自回归的思路。虽然与线性判别分析在算法上是完全不同的,但本质上是一样的,即通过各种变换来提升分类能力。

有了好的预测能力,如何验证呢?一种是定量指标,我们能在论文中看到大量的刷分表格和图。除了常见的定量指标外,深度学习的论文还特别喜欢用t-SNE(t-stochastic neighborhood embedding, 即t分布的随机邻域嵌入)来证明模型的分类能力。t分布的随机邻域嵌入是辛顿在深度学习以外的另一大杰作,诞生于2000年盛行的流形学习时代,主要是试图恢复嵌套在高维空间的低维流形。比如将一个三维空间的S形或Swiss-roll数据在二维空间摊平。最初提出的随机邻域嵌入(SNE)在把内在较高维的流形投影至比其维度低的空间时,会出现坍缩现象。为保证投影低维间,数据间的距离能保持一致,于是将高低维的数据均假设成t分布。实验表明其恢复流形的效果是不错的。不过,该方法在流形学习时期并不算特别出彩的,因为其它流形学习能更好地摊平一些已知流形的结构,如当年流行的等度规映射(ISOMAP)。但是,t-SNE的好处在于开源的可视化算法做得不错,在后流形学习暨现在的深度学习时代,反而成了最常用的检测模型分类性能的工具。一种新方法要定性证明它的性能好,通常会用t-SNE将模型获得的特征表示降维至二维空间再将不同类别用不同颜色显示出来。如果能明显分开,则表明模型的预测性能好。

然而,从多数论文中t-SNE可视图的效果来看,也不难发现另一层的意思。即多数模型执行了线性判别分析的思路,使得类内尽可能接近,类间尽可能远。从预测的角度来看,它是不错的;但从可解释性的角度来看,它实际上坍缩了数据原本应有的几何结构,也就自然会损失掉不少隐含在其中的可解释性。或许,这些解释性也是人类真正需要的知识。

通过以上分析,就能理解,我们现阶段的模型为什么高度依赖高质量数据。这种数据通常来说,肯定是越多越好。它也是目前人工智能领域普遍认为通过AGI、甚至ASI必不可少的一环。

但是,是否必须走这条路才可能实现通用人工智能呢?且听下回分解。

https://blog.sciencenet.cn/blog-3389532-1522042.html

上一篇:高校科研:AI时代的论文之殇

下一篇:高校科研:AI时代的论文版面费之诘问