博文

失控:脑补的生成式AI  精选

精选

|

前一阵有天在街上遛狗,发现路边上停了辆非常卡哇伊的车,外饰是迪斯尼的卡通人物图案。无巧不成书,那天开车出门不久,又见到一辆也贴了迪斯尼另一卡通形象的车。我差点以为是迪斯尼的广告车或专车了。但仔细一想,应该是在已有的车上贴了层定制图案的车膜,以至于看起来就像换了车似的。上网一查,果真如我所料,只是漂亮的车身贴膜。看着价格还能接受,忍不住有点想把自己十多年的老车装饰下,不过想着钱要用在刀刃上,就打止在念头里了。

~~~~~~~

最近人工智能领域,风头正劲的是文生图、文生视频、文生音乐。尽管产生了无数眼花缭乱、令人惊叹的图画、视频、音乐,但不管是Pika,Sora,Suno,还是OpenAI最新推出的GPT-4o,但如果仔细想想,这种生成式AI的做法,又何尝不类似我见到的贴膜呢。

如果把(大)模型比喻成车体,生成图像、视频、音乐过程中用来训练的数据集比喻让车子跑起来的燃油,这部分软硬件包含了与车体90%以上相关的信息。如果再把提示词比喻成让车增色的车膜,那么,这包含全车不到10%价值的脑补,却可以让人们以为自己获得了全新的创造力。因为艺术创作里的曾经高门槛,现在已经被生成式AI生生拉低,普通老百姓也能时时刻刻产出新颖的作品。真是“旧时王谢堂前燕,飞入寻常百姓家”。

虽然如此,我们也需要冷静思考下,在这创作的过程中,人们投入的工作量究竟有多大。

要回答这一问题,不妨换个角度,从图像的中低频分解来解释下。

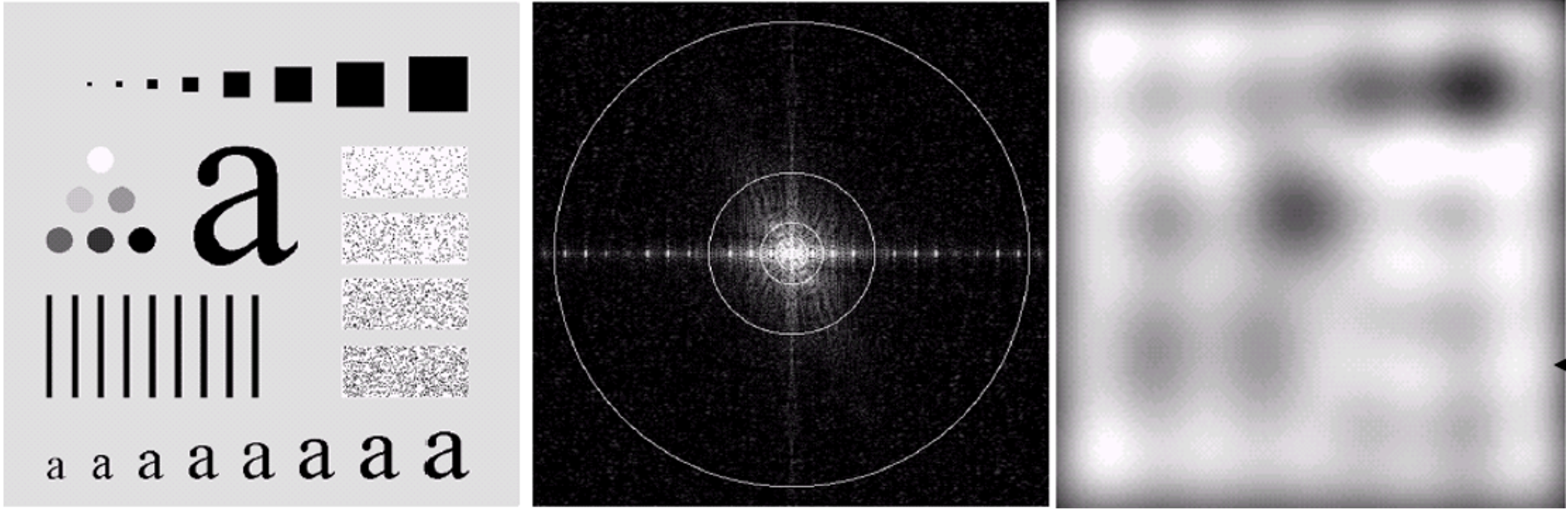

图1: (左)500x500像素的测试图;(中)在傅里叶谱空间表现的能量谱。其中92%的能量分布在中心化后的5x5小圆里;(右)5x5能量谱还原了原图的基本结构(图来自冈萨雷斯的《数字图像处理》(第三版))

图1是我给本科生上数字图像处理课常用的一张测试图。如果将此图通过傅里叶变换转换到由若干不同周期的三角函数加权组合而成的频域空间,那么频域空间每个频率上的分量便是图上所有像素在此频率下的傅里叶变换累积和。虽然与图同尺寸的频率图拥有百分百的能量谱,但对于500*500的原始图像,在中心化的频域空间上,5*5的尺寸却已经集中了92%的能量。

这部分能量控制了原始图像的整体结构。就像控制了车和燃油的软硬件部分一样。尺寸虽小,系数的份量却很重。而剩余可探索的空间虽大,系数值却都不大,且是在92%的基础上制造细节,完成对结构的“贴膜”。但就是这些小小的改变,却能让人在视觉上、听觉上产生深刻印象,甚至以为人工智能快要变天,离通用人工智能不远了。

尤其是生成式AI在主导当下人工智能发展方向的时代,“生成”似乎成了一种约定既成。模型训练完成后,我们只需要做一点小小的努力,输入一组提示词或一段文字表述,或一张草图,生成式AI就自动给我们脑补出相应的图像、视频或音乐。

在这一过程中,高质量训练数据的标注是其中最重要最关键又最能提升性能的一环节。由于生成式AI极度依赖数据标注,要让模型的性能进一步提升,仅靠人力标注,量不够且影响生成标注的时效。于是,对巨量数据标注的方式,正从人工标注,走到大模型辅助标注人工忽略的区域,再进入到模型全自动标注的阶段。比如Meta公司推出的分割一切模型SAM(Segment Anything Models)[王淼等,2024]。

生成式AI和以往的机器学习不同。从前我们在寻找答案时,总希望找一个理论上的最优值。而脑补的生成式AI则没有如此限制,每次生成都有千万种可能,只不过它能挑出一个或一组它认为最优的或近优的展示出来。但其它未展示的候选解也不一定差,甚至有可能更好。而我们也只是根据其展示出来的,来后知后觉的分析其好的原因。

然而,在这一被广泛认同的数据标注策略和生成式AI背后,却有三个潜在的问题或风险:

归纳偏置。按照Scaling Law,AI大模型的精度在参数规模超过某个阈值后其性能会快速提升。这一现象的成因虽不清楚,但它与数据量的大小脱不了干系。而后者的标注由于量级的变化,AI自动标注是不可避免,也因此无法避免归纳偏置问题。

比如以前人类标注时,有一个典型案例,如何从图像中识别阿拉斯加犬和哈士奇。最开始发现模型性能不错,但分析数据集发现其实识别的是图像里的冰天雪地。只有背景有雪,就是阿拉斯加犬。这是数据集收集时出现的问题。而最近也有一例。比如某手机曾推出的一键消除功能,如果用在女性上半身,便会变身为火辣身材的形象。这从某种意义来说,是人工智能生成数据训练后导致的结果,但多少也反映了设计算法者或收集数据者的品味。

而进入人工智能自动标注时代,当十亿级甚至更大规模数据集出现时,我们已经很难发现其中对某些小细节的归纳偏置,尽管有文献在研究如何避免,但最多能部分解决一些相对大的偏置。况且,只要存在这种偏置,我们就很有可能被其带偏。如果习以为常,更有可能被生成式AI这些隐含的规矩所牵制,而不能自拔。据说,现在围棋界已经无法摆脱用AlphaGo发现的开局来下棋,否则无法取胜,导致现在的棋局变得没有以前那么有大家个性化的开局风格。也许,生成式AI也会不知不觉让人类在众多领域如绘画、音乐等,被AI所主导。

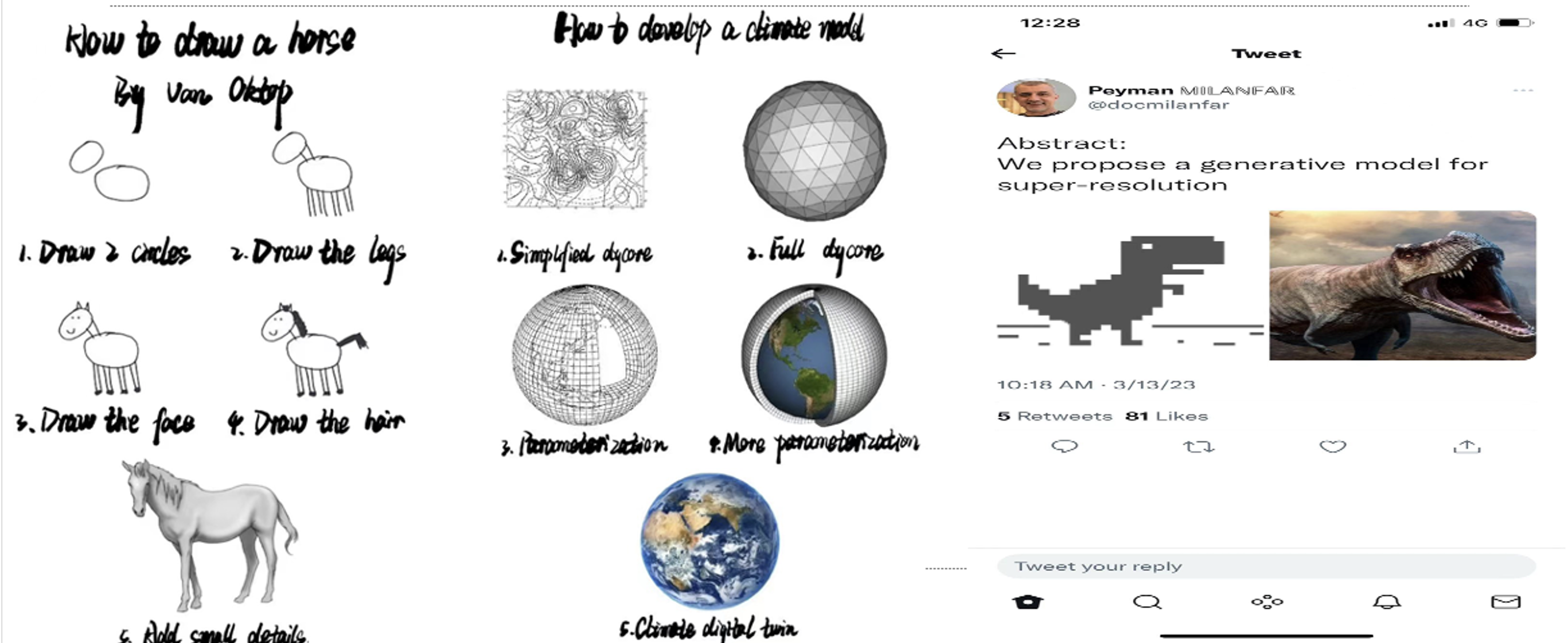

脑补式创作。目前基于大模型的创作,主要以提示词和语言对话的形式来实现。音乐的创作则可以通过输入一段歌词,指定风格和人声等来完成。一方面,这种方式极大的降低了人类创作的门槛,原有认为艺术需要的童子功,被大模型轻松替代了不少。现在的基于AI的创作更像是傻瓜相机上的后加工。另一方面,人类在其上创作中占的比重似乎变得微乎其微,有点像“画龙点睛”式的贴膜。聊聊片语,便生成了人类以为满意的画作。但实际上,底子是AI的,人类只是用提示词粗粗指了个方向,还并不精确。但AI就像个聪明的下属,对人类的指令心领神会,画得让人十分满意。其实本有千百种可能,但只是将其中几种呈现出来。因为AI清楚,多数人类并不知道自己真正想要的画是啥样,AI也清楚自己也不清楚,但依然可以用概率自信的画出来。如果说一图胜千言,那么在生成式AI脑补时代,似乎是一言成千图,图图皆迥异。从贡献来看,显然是AI占的比重更大。而人类只是用提示词在AI制图的基础上贴了层膜,便成了“自己”创作的作品,但是基础仍是AI说了算。

图2: 脑补式创作(图来自网络)

杰作与海量。据说人工智能短短两年创作的作品数量已经超越了人类文明所拥有的。这不是任何人可以以其脑容量能记得住的。比如一个人如果微信好友突破5000后,就可能出现脸盲的障碍。而上百亿上千亿的AI作品的出现,有可能同样会物及必反,导致能记住的作品、或对人类有意义的作品,变得聊聊无几。

那如何能让一个AI作品真正成为杰作呢?固然,我们能看到《太空歌剧院》获得冠军,但这有可能是在不熟悉它的成画模式下,感受到的新奇。一旦发现后续的创作,都有着似曾相识的套路化时,可能就不会再高看了。而反观人类的画作,很多杰作的出现并不是仅仅作品本身,还有背后的故事在支撑。比如梵高的画,之所以有名,不是只因为画得有多精彩,还有其背后的励志故事,引起了人们对画作和作者的共情。

那么,除了巨量的“高质量”数据、上十亿百亿级的深层大模型、强计算能力的显卡集群外,人工智能创作的艺术作品会有励志的故事吗?如果没有,即使画得再好,也很难让人最终形成共情的印象。即使好听、好看,人们也许最多不过会表示下惊叹,然后AI作品便会淹没在AI快速发展的滚滚洪流里。如果有,那究竟会是什么,又如何量化这些Ai的励志因素呢?

在上述三个问题里,个人以为,归纳偏置对AI的发展可能最重要。如果说1974年莱特希尔报告里提及的组合爆炸问题,导致了人工智能的第一次寒冬。那么,这一拔生成式AI的寒冬,如果来临的话,有可能是因为无法彻底解决归纳偏置,导致失控的AI生成引起。

参考文献:

王淼,黄智忠,何晖光,卢湖川,单洪明,张军平. 2024. 分割一切模型SAM的潜力与展望:综述. 中国图象图形学报,29(06):1479-1509[DOI:10. 11834/jig. 230792]

https://blog.sciencenet.cn/blog-3389532-1436167.html

上一篇:人工智能的极限:智能拼卡时代

下一篇:为何今年诺贝尔物理学奖颁给两位人工智能学者?谈人工智能的历史变迁及对人类社会的影响