博文

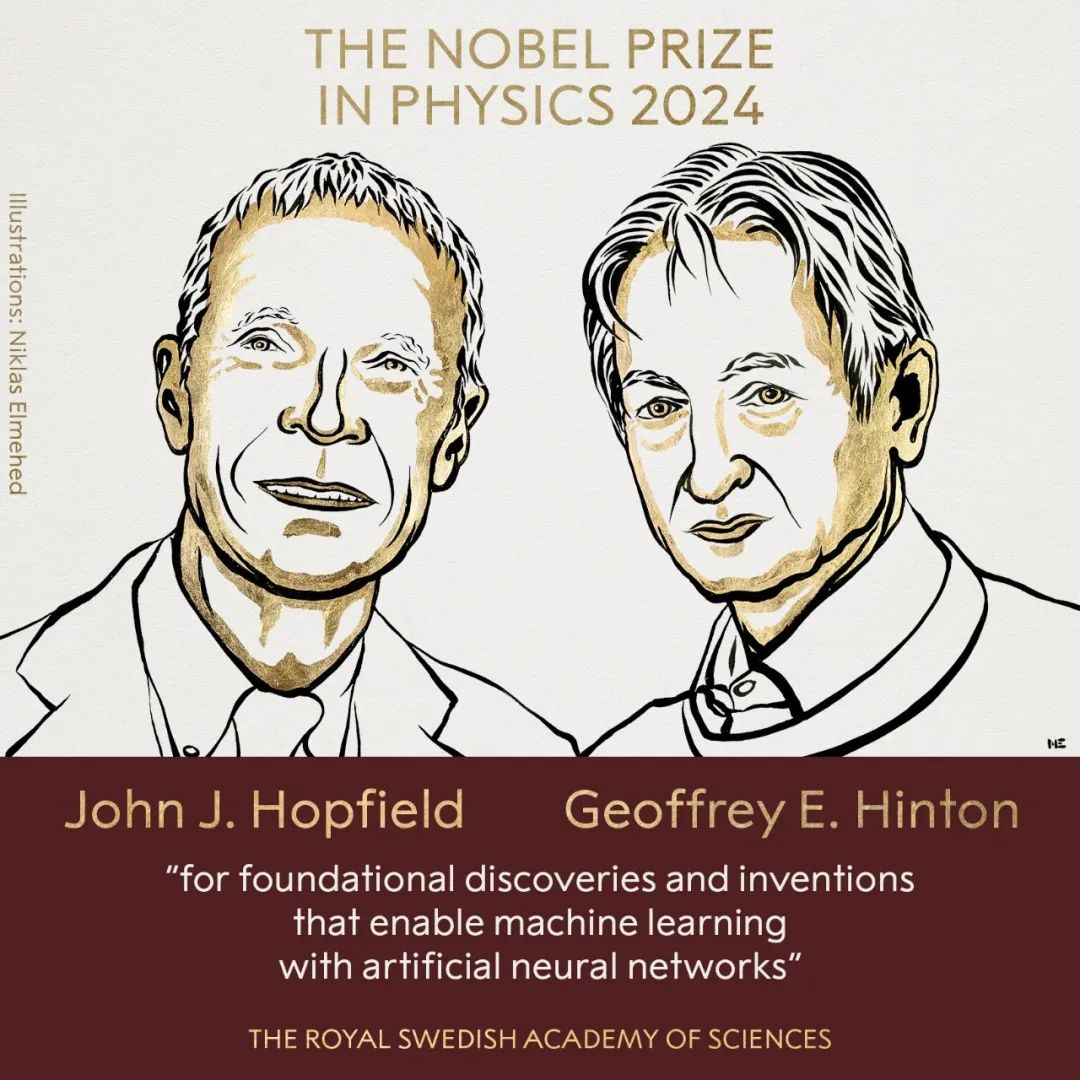

John J. Hopfield and Geoffrey E. Hinton

|

💡诺贝尔物理学奖:10 月 8 日,诺贝尔物理学奖授予了约翰・J・霍普菲尔德(John J. Hopfield)和杰弗里・E・辛顿(Geoffrey E. Hinton),表彰他们在利用人工神经网络实现机器学习方面的发现和创新。诺贝尔物理学奖的颁发,表达了人们对人工智能领域在物理学层面应用的高度认可,也标志着人工智能在科学领域的重要地位日益凸显。曾经,人工智能被视为科幻小说中的想象, 而如今,它已经成为推动物理学发展的强大动力,为解决复杂的物理问题提供了新的思路和方法。

约翰・J・霍普菲尔德:1933年,Hopfield出生于美国伊利诺伊州芝加哥的一个波兰裔家庭。他的父母都是物理学家,这为他从小接触科学、探索物理世界提供了得天独厚的环境。儿时的Hopfield经常拆装家里的各种电器,这种对未知世界的好奇心和探索欲,为他日后的科学研究埋下了伏笔。1950年,Hopfield考入斯沃斯莫尔学院(Swarthmore College),在这里接受了扎实的物理学基础教育。1954年本科毕业后,他进入康奈尔大学攻读物理学博士,师从著名物理学家Albert W. Overhauser。在康奈尔大学的学习期间,Hopfield不仅掌握了深厚的物理学知识,更重要的是,他学会了从一堆理论上可行但实验上无法验证的悖论中,找到要研究的问题与方向。这一方法成为他日后科学研究的重要指导思想。博士毕业后,Hopfield被聘任到贝尔实验室的理论小组工作。贝尔实验室作为当时科研的殿堂级机构,吸引了众多科学巨匠,如1977年诺贝尔奖得主P.W. Anderson等。在这里,Hopfield不仅与同事们共同攻克了许多科研难题,还结识了日后对他产生重要影响的科学家。

约翰・J・霍普菲尔德的主要发现:

1. 基因表达中的 “动力学校对”:1974 年,霍普菲尔德证明基因表达中存在的高精度可以通过称为 “动力学校对” 的偶联化学反应来解释。这一发现为遗传学领域做出了重大贡献,让人们对基因表达的精确调控机制有了更深入的理解。

2. Hopfield 神经网络:1982 年,霍普菲尔德提出了 Hopfield 神经网络(HNN)。这是一种简单的神经网络模型,能够解释神经元系统如何相互作用以产生稳定的记忆。神经元可以处于两种状态(0 表示 “不激发”,1 表示 “以最大速率激发”),神经元之间的连接具有一定的强度。通过类比描述磁性系统的数学方法,霍普菲尔德为该系统定义了一个 “能量” 概念,使得记忆处于系统的最低能量状态。这种网络能够存储多个模式,并且在获得不完整或者有噪声的输入信息时,依然能够重构出最相似的存储模式。 在1984 年,他还设计出该网络的电子线路,为人工神经网络模型的可用性提供了物理证明。

总的来说,霍普菲尔德的研究领域具有很强的跨学科性质,涉及固体物理学、分子生物学、神经科学以及计算机科学等多个领域。他将不同学科的知识和方法进行融合,扩展了统计物理学的边界,使其涵盖生命现象,从分子水平信息传输的动力学校对到神经网络的动力学,创建了一种用于思考大脑计算的新语言,这种跨学科的研究思路和方法不仅对科学研究的发展具有重要的启示意义。而且,“动力学校对” 推动了遗传学的发展, Hopfield 神经网络为人工智能和神经网络的发展奠定了基础,这些研究对神经科学、计算机科学和优化问题等领域产生了深远的影响。

杰弗里・E・辛顿:Geoffrey Hinton 出生于 1947 年,他的成长环境与普通孩子不同。他的祖父 George Boole 是布尔代数的创立者,而他的家族中也有不少杰出的科学家,Hinton 的家庭充满了对科学和数学的讨论。祖父的布尔代数发明不仅是计算机科学的奠基石,也深深影响了 Hinton 的思维模式。从小,他耳濡目染,科学问题成为日常讨论的话题。这种环境培育了他对科学的好奇心,尤其是对大脑如何处理信息的深切兴趣。作为一个好奇心旺盛的孩子,Hinton 并没有拘泥于单一的学术领域。相比许多学者从一开始便确定自己的研究方向,Hinton 的学术之路是一条多次调整、不断探索的曲折旅程。他对大脑运作的兴趣在早期便已显现,这种好奇心逐渐演变为他一生的学术追求,最终将他引领到人工智能领域。

杰弗里・E・辛顿的主要发现:

1. 误差反向传播算法(Backpropagation Algorithm):1986 年,辛顿与大卫・鲁梅尔哈特(David Rumelhart)等人提出了适用于多层感知机的误差反向传播算法。在此之前,多层神经网络的训练是一个难题,而该算法通过计算输出层的误差,反向传播到各层神经元,调整网络的权重和偏置,使得神经网络能够有效地进行训练,这为后来深度学习的发展奠定了重要基础。

2. 玻尔兹曼机(Boltzmann Machines):1983 年,辛顿发明了玻尔兹曼机。这是一种基于能量的随机神经网络模型,能够学习复杂的概率分布。它为神经网络引入了概率计算的思想,使神经网络能够处理不确定性问题,并且在一些复杂的任务上取得了较好的效果。后来简化后的受限玻尔兹曼机被应用于机器学习,成为深度神经网络的层级结构基础。

3. 深度信念网络(Deep Belief Networks):2006 年,辛顿发现拥有多个隐藏层的神经网络能够具有自动提取特征学习的能力,相比传统的手工提取特征的机器学习更有效果。并且通过逐层预训练的方式可以降低多层神经网络的训练难度,解决了长期以来多层神经网络训练的难题。他将这一研究成果发表,并将该模型命名为 “深度信念网络”。

4. 对卷积神经网络的理论贡献:虽然杨立昆通常被认为是卷积神经网络的发明者,但辛顿也对这一领域有重要贡献,尤其是在理论方面帮助理解卷积神经网络如何以及为何有效工作。

辛顿的这些发现和贡献对人工智能和机器学习领域产生了极其深远的影响,推动了深度学习的发展和广泛应用。他也因此被誉为 “人工智能教父” 和 “深度学习之父”。

总的来说,霍普菲尔德和辛顿的发现,为利用人工神经网络进行机器学习提供了重要的理论基础和方法,对人工智能领域的发展起到了极为重要的推动作用。

https://blog.sciencenet.cn/blog-3612310-1456076.html

上一篇:人工智能在科学研究中的应用:机遇与挑战

下一篇:Nikola Tesla