博文

【李白对话录:你波你的波,我粒我的粒】

精选

精选

|||

白:

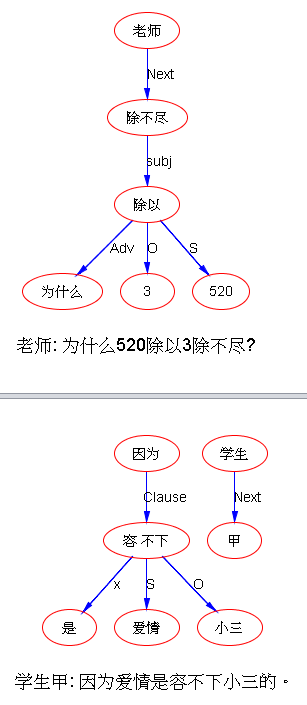

转:老师:为什么520除以3除不尽?

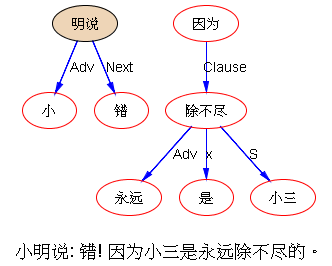

学生甲:因为爱情是容不下小三的。

小明说:错!因为小三是永远除不尽的。

老师

:

“都给我滚出去‘’ 520/

3=173.3333333333333333333 前面1个妻后面全是小三

Qing:

白老师好雅兴啊

白:

除不尽……这不是NLP的好例子么

李:

哈 小明 切错了

白:

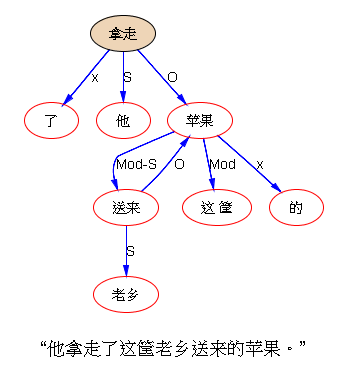

“他拿走了这筐老乡送来的苹果。”

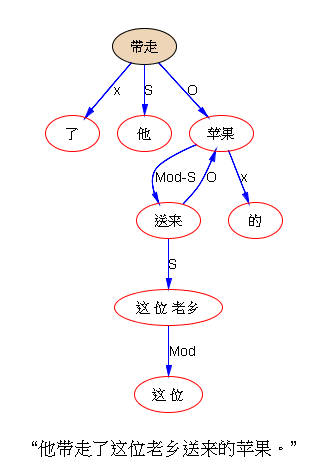

“他带走了这位老乡送来的苹果。”

我:

刚看第一句,心里想这不是中规中矩的句子吗,白老师又在玩什么 catch 呢。接着看到第二句,原来还是量词。量词一个月前已经做进去了。

白:

筐这个,是多对多的搭配,不是一对多

李:

不就是容器做量词

白:

对,动用subcat

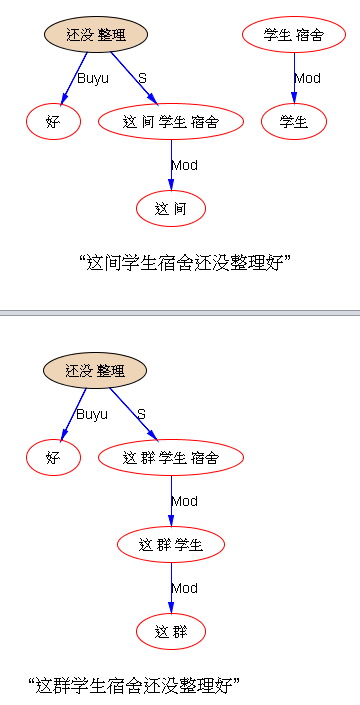

“这间学生宿舍还没整理好”

“这群学生宿舍还没整理好”

“这帮学生宿舍还没整理好”

李:

当然。说解决了量词问题,当然不是只解决直接量的搭配,其中包括 subcat 里面有一系列从具体到抽象的量词搭配。

白:

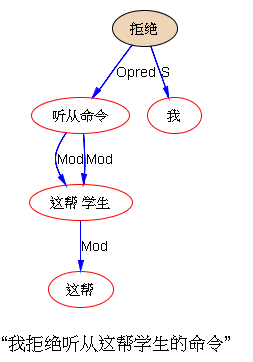

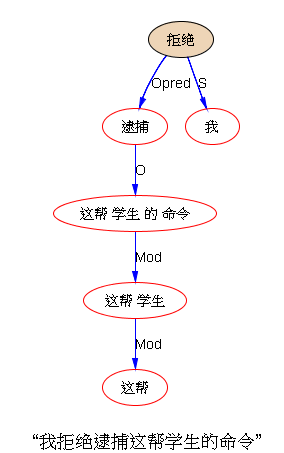

“我拒绝听从这帮学生的命令”

“我拒绝逮捕这帮学生的命令”

李:

第二个错了。

两个 subcats? 拒绝逮捕 vs 拒绝命令?

白:

逮捕的逻辑宾语不能是抽象的。

李:

逮捕+human;拒绝+VP;拒绝+NP (拒绝+命令?)

被 subcats 弄得有点糊涂了。

到底“拒绝”的是一般的 N 还是直接量的“命令”

对,“命令”不能“逮捕”。

还有个好玩的:“拒绝逮捕” 实际上是 “拒绝[被]逮捕”。因此如果“逮捕”做了“拒绝”的宾语,那么“逮捕”自己就不能再有宾语,因为它是别人的隐含宾语。这套逻辑属于啥?应该是语言学内部的某种。

白:

命令属于没有提取功能的N,只能被饱和的定语从句修饰。当然如果动词是“执行”等硬搭配,例外。

李:

这个句子值得咀嚼。

命令是有human的坑的,因为有坑,因此让“这帮学生”与“命令”勾搭起来也就有了依据。没想到的是前面是“逮捕”,也有个 human 的坑,与命令不搭。于是麻烦来了:一个动词与一个动名词,一个从左一个从右,在争抢这个 human,典型的 triangle,情何以堪?

白: 哈

李:

以后这个句子是个保留的 test case,哪家中文做好了,就拿它考考。看深度神经是不是有更好的办法绕过它去。

白:

动名词的坑在竞争中处于劣势

李:

竞争劣势是普适吗?

V1+V2+de+N 中,V1 胜过 V2,如果都符合坑的要求的话。这个 heuristic 有多大把握?

而且这句 V1+V2 恰好也符合 subcat,V2 也可以跳进 V1 的坑。

还是没弄清楚 为啥 V2 一跳进去就变成被动了,一般的带有动词的subcat,对于动词是没有约束的:V+VP,后面跟的是 VP,而不是一个明示或隐式的 passive V。为啥“拒绝”偏偏不同于众呢?

拒绝逮捕 == 拒绝被逮捕

but 拒绝离开 <> 拒绝被离开

但似乎,拒绝洗礼 == 拒绝受洗?

可:

拒绝吃猪肉,拒绝看电影,拒绝谈朋友。。。这不都好好的 VP 吗?为啥“拒绝逮捕”不同?当然例外在语言学中是常态,不需要讲道理的,直接encode到词典subcat去即可。这种不同(拒绝+VP vs 拒绝+逮捕)是 subcat 的个性共性在这个词上的反映,约定俗成。那么也简单,就直接 encode 到 subcat 里面去。

然而,这样一来,这场 subcat 大战就超出了三角,这个case就更乱成一锅粥了。

“拒绝”要抢“逮捕”,比“拒绝”要“命令”,道理上似乎更强大,可这个case正好相反。“拒绝”抢“逮捕”是直接量的 subcat,而且两个挨得那么近,所以应该是优先的,而“拒绝”与“命令”似乎不能算直接量的 subcat,而是一般及物动词带NP的一种,因此单单看这一对的subcat的强弱程度,搭配的力量对比上应该后者是抢不过的。

白老师能想出这个案例,也是醉了。里面太多的语言学纠缠了。

白:

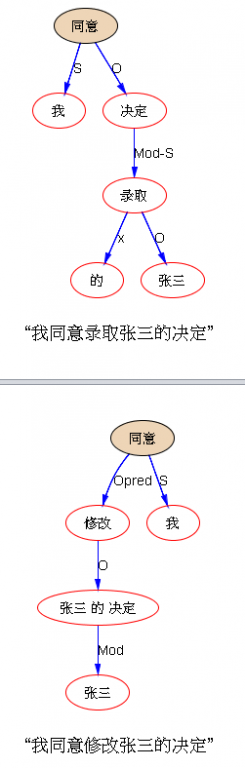

“我同意录取张三的决定”

“我同意修改张三的决定”

李:

不知道是不是狗屎运。其实如果不仔细查看,我也不知道是不是运气,还是啥时教给它了,当然宁愿相信是天道酬勤,毕竟狗屎运是小概率。

其实做中文除了架构设计还有毛毛虫模型等战略高度的考量,90% 的时候就是一个苦力。不说别的,就说这词典,每次进去就感觉头皮发麻,哪里哪里都不顺眼。怎么有那么多工作量啊,简直感觉这一辈子搭进去也不见天日似的,吾生之有涯对无涯,大大地殆矣。

有人以为词典不就一个词表吗?到大数据扒拉一遍,要多少万给多少万,很多基于大词典的切词程序就是根据大数据 ngram 扒拉出来的。

可是要把语言学(包含subcat)融入词典,再把 ontology 带入,然后再考虑歧义词的某种特别标注,等等,够累死n头牛的。

我总觉得自己当年学《老三篇》,学得了愚公精神的精髓,以苦为乐,即便如此,有时还是免不了林彪元帅的天问:红旗到底要打多久?

有时候也想,如果深度神经真能把这些都一揽子搞定,只要给它喂 data,最好是原始的data,标注都不需要,语言学就自动学会了,那该是多么美妙啊。今后20年内能等到这一天么?

白:

用不了

李:

学习乐观主义(cf:【泥沙龙笔记:学习乐观主义的极致,奇文共欣赏】 ),据说程序猿今后五年都要淘汰了。

白:

关键是找到规则和统计的正交坐标系,实现波粒二象性。

李:

白老师要是有这个信心,我愿意给你打下手,促成大业。你波你的波,我粒我的粒,按照你的设计哲学。

【相关】

https://blog.sciencenet.cn/blog-362400-978673.html

上一篇:【新智元笔记:巨头谷歌昨天称句法分析极难,但他们最强】

下一篇:【泥沙龙笔记:自然语言技术落地,主餐还是副食?】